La civilisation techno-animiste

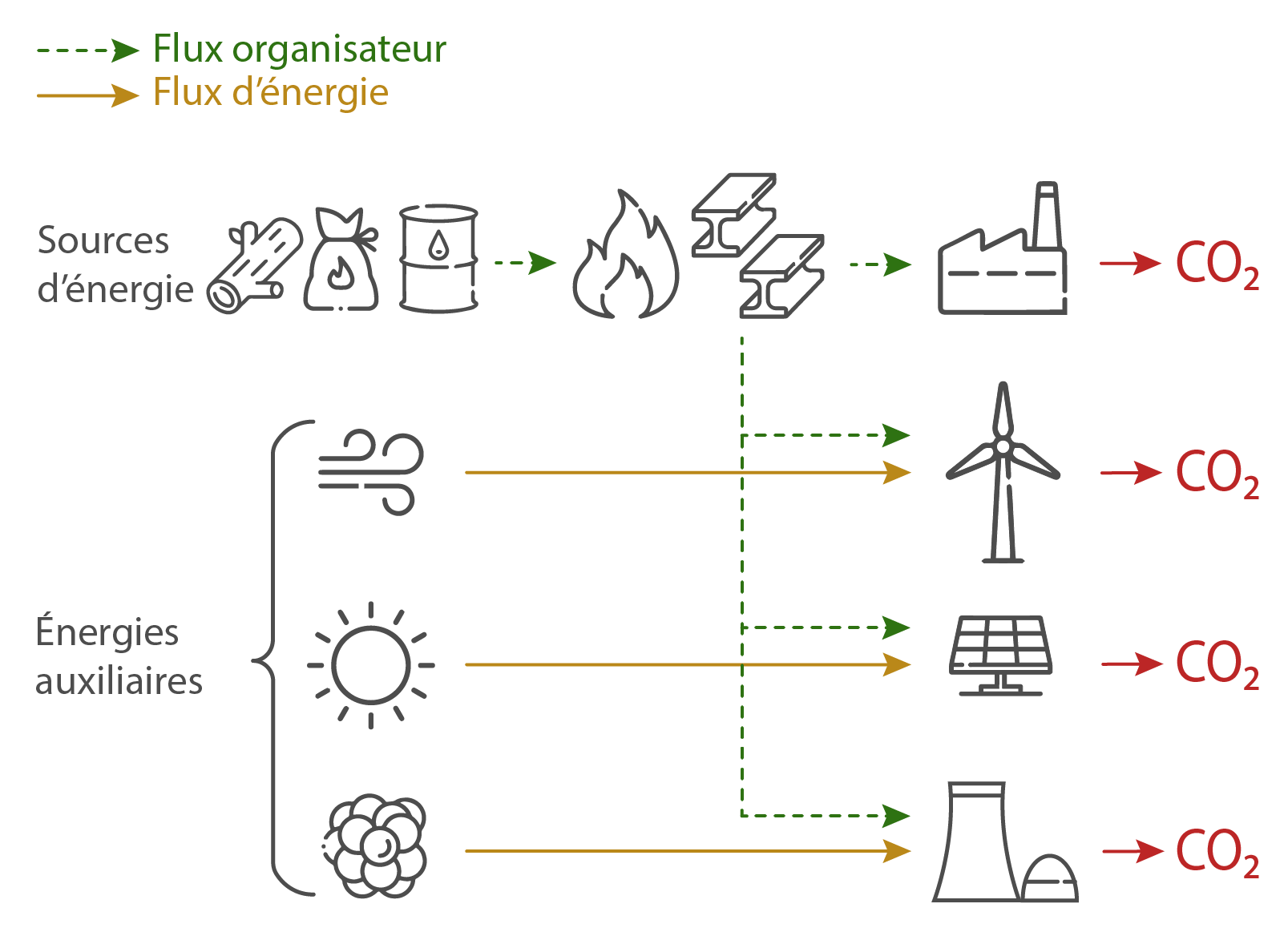

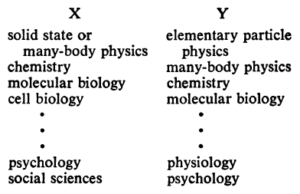

Tenter d’affranchir les sociétés humaines de leur dépendance à leurs seules sources d’énergie connues implique de tenir compte des acquis scientifiques sur les conditions à l’auto-organisation des systèmes physiques. Les conditions à la stabilisation des sociétés humaines ne sont pas réputées honorées par les interactions que celles-ci peuvent établir avec les infrastructures de conversion de l’énergie provenant du vent, du rayonnement solaire ou des atomes (ENS). Ces infrastructures, en particulier, ne sont pas dotées des propriétés des systèmes auto-organisés que constituent les organismes vivants. La confusion entre les propriétés des machines et celles des êtres vivants invite à s’interroger sur les croyances développées au sein d’une civilisation techno-animiste.

Défi énergie #5

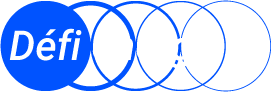

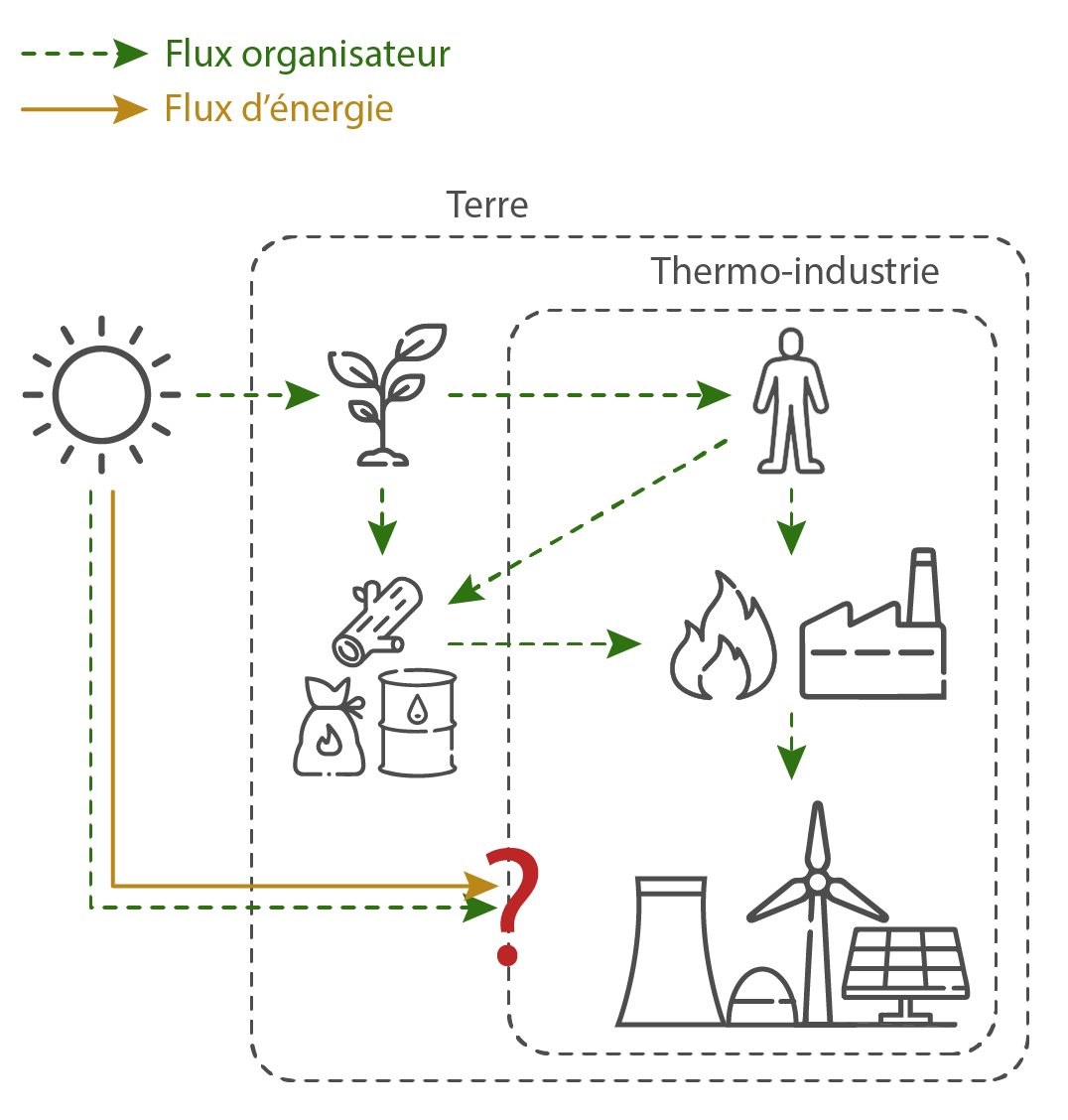

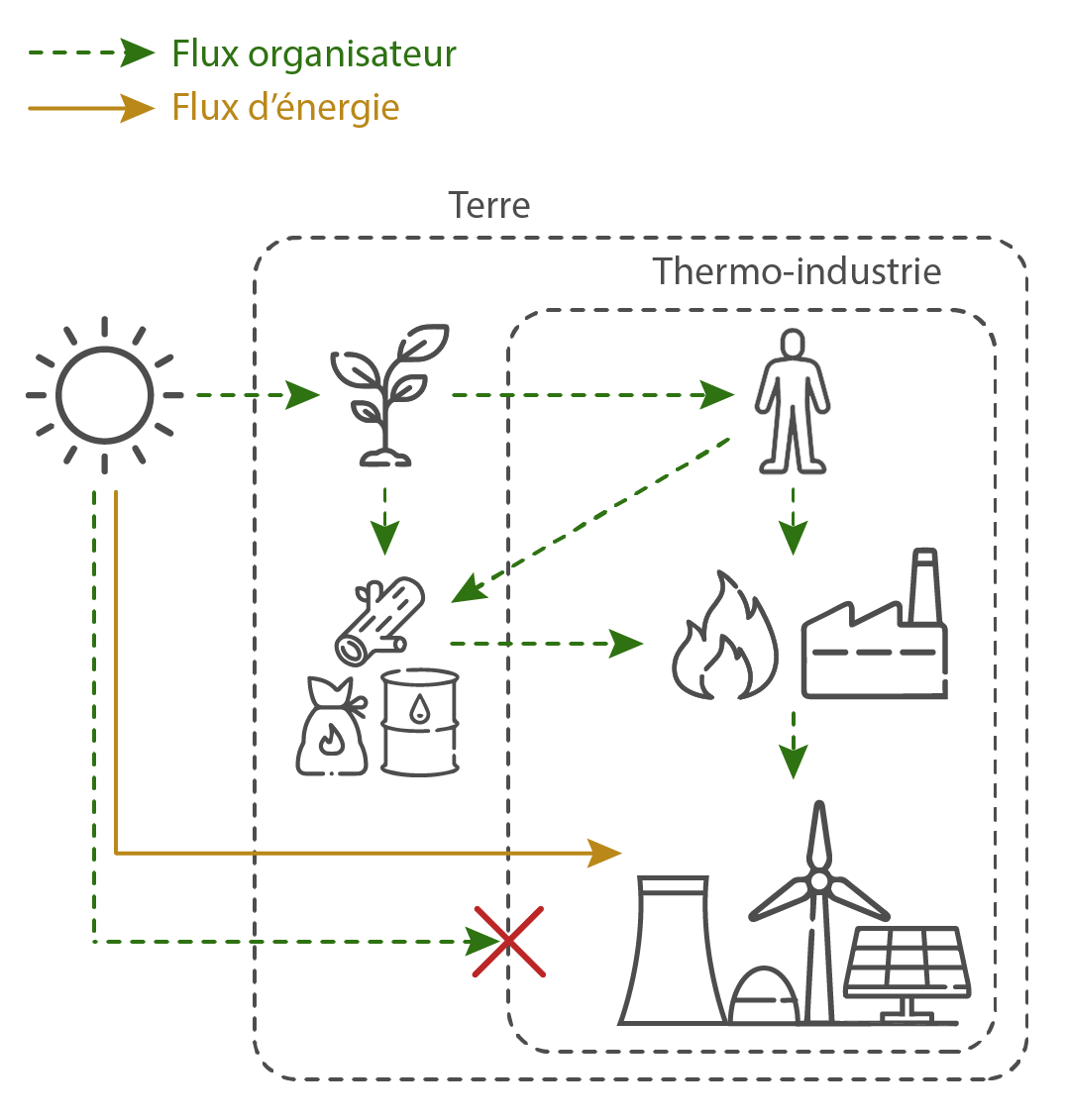

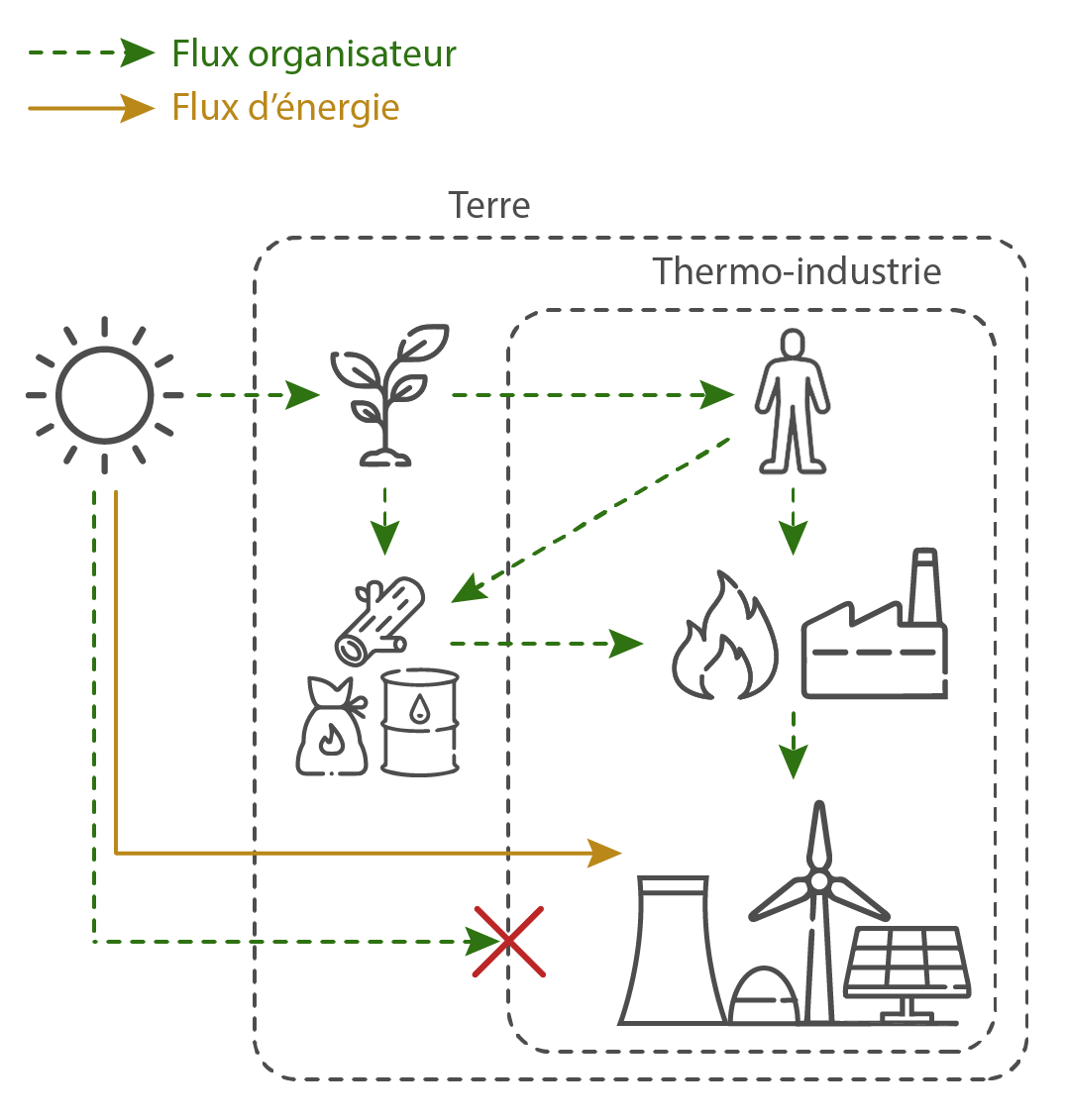

La substitution des énergies serait possible si les sociétés thermo-industrielles constituaient des systèmes physiques ouverts (au sens de l'accès à l'organisation) sur l’énergie provenant du vent, du rayonnement solaire ou de l’énergie atomique.

INDIQUEZ LES SOLUTIONS ➤

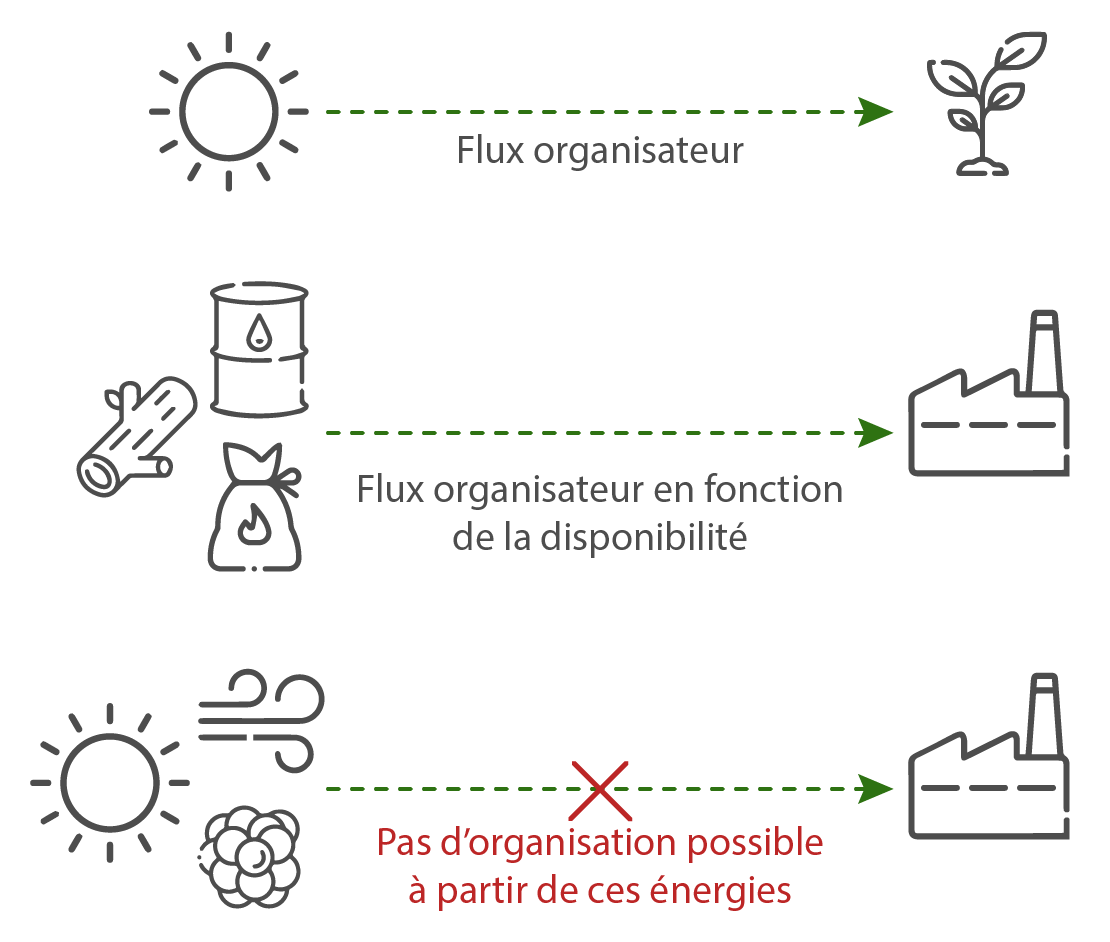

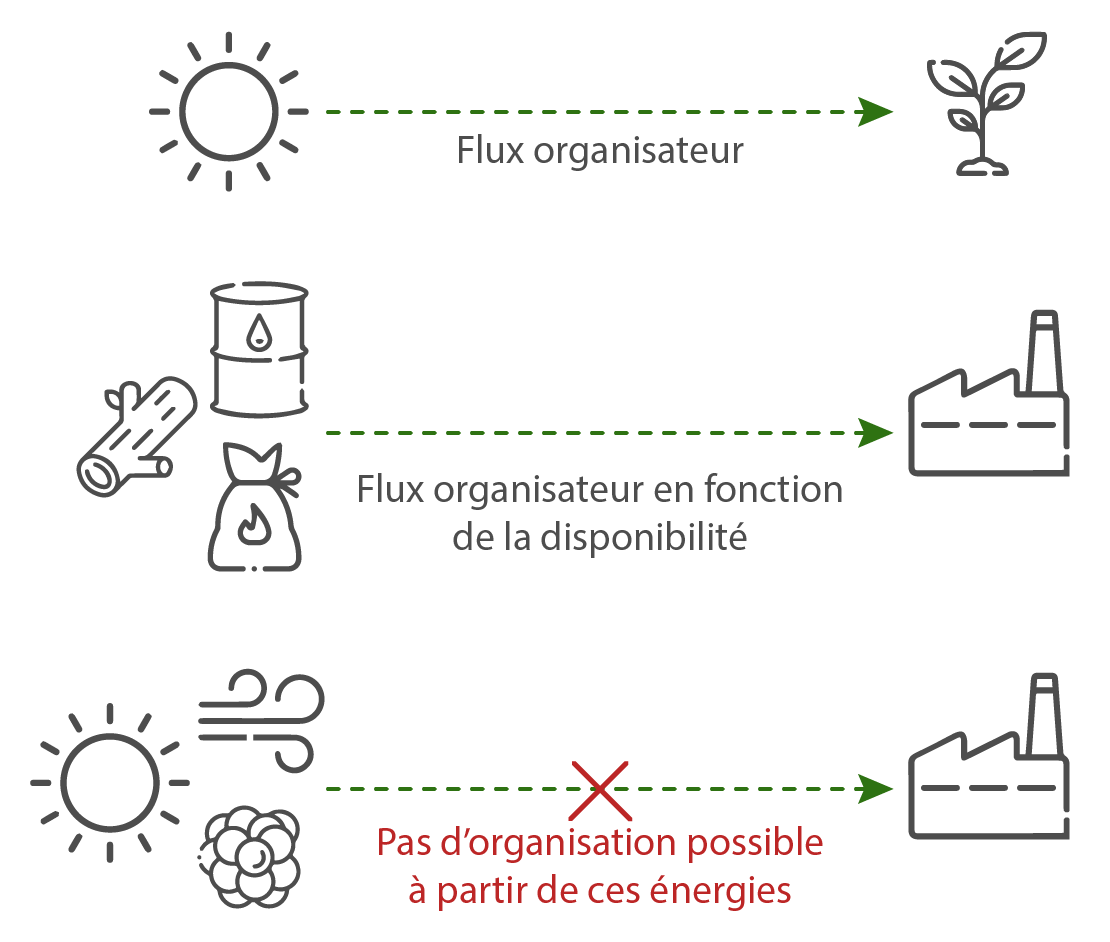

Dans le contexte de l’étude d’une transition énergétique par substitution des énergies, différents critères peuvent être choisis afin de définir les frontières des systèmes physiques constitués par les sociétés humaines. Ces frontières permettent de caractériser les types d’interaction ces systèmes établissent avec leur milieu. Le critère retenu ici est celui de l’interaction donnant accès à un “flux d’entropie”, c’est-à-dire à un flux d’énergie permettant l’organisation des sociétés humaines (flux organisateur).

Les systèmes constitués par des sociétés humaines stables sont, par défaut, ouverts sur la matière organique sous forme de biomasse comestible, qui constitue leur seule source d’énergie, leur seul flux organisateur. Toutefois, les sociétés humaines qui exploitent la matière organique uniquement sous forme comestible (source d’énergie vitale), ou en exploitant en plus la biomasse et les hydrocarbures (sources d’énergie auxiliaire) constituent des systèmes physiques aux frontières différentes.

- L’exploitation de la seule alimentation définit l’humanité en tant que système biologique, ouvert sur la matière organique comestible. Dans ce cas, le système humain est considéré isolé de l’énergie pouvant provenir de la biomasse combustible ou des hydrocarbures : l’énergie alimentaire n’est pas convertie en force de travail qui permet d’exploiter ces sources d’énergie auxiliaire. Le système biologique constitué par l’humanité est, dans cette situation, fermé à certains échanges de matière spécifiques, si l’on considère la matière qui ne pourrait être exploitée que grâce aux sources d’énergies auxiliaire que sont la biomasse combustible et les hydrocarbures (par exemple, les métaux pour la fabrication d’outils).

- L’exploitation de l’alimentation accompagnée de l’exploitation des sources d’énergie auxiliaire (biomasse combustible et hydrocarbures) fait des sociétés humaines des systèmes ouverts sur la biomasse comestible et ouverts sur le flux organisateur provenant des sources auxiliaires. Dans ce cas, les systèmes humains ne sont fermés que sur la matière qui ne peut pas être exploitée grâce à l’ensemble des sources d’énergie que l’humanité exploite (par exemple, jusqu’à aujourd’hui, les minéraux présents dans les couches géologiques au-delà de 12 262 mètres de profondeur restent physiquement inaccessibles – Voir source ci-dessous).

- Selon le critère d’accessibilité à un “flux d’énergie permettant l’organisation des sociétés humaines” (flux organisateur) pour définir les systèmes humains, aucun n’est ouvert sur les énergies auxiliaires, pourtant présentes dans le milieu dans lequel évoluent ces systèmes. En effet, ni le vent, ni le rayonnement électromagnétique, ni l’énergie des atomes ne constituent des flux d’entropie susceptibles de contribuer directement à leur organisation. Des sociétés strictement éolo/photo/nucléo-industrielles seraient physiquement fermées à l’exploitation de quelque matière que ce soit.

Sources

Source :

Richard P. Feynman, Robert B. Leighton, Matthew Sands, The Feynman Lectures on Physics, Addison-Wesley, 1970.

Article “Thermodynamic laws in isolated systems”

Ce débat a révélé certaines idées fausses très répandues sur la signification générale de la température dans les systèmes isolés. Par exemple, il est souvent affirmé [10-12] que la connaissance des températures microcanoniques suffit pour prédire la direction du flux thermique. Cette affirmation, qui est souvent considérée à tort comme équivalente à la deuxième loi, est vraie dans de nombreuses situations, mais pas en général, reflétant le fait que l’énergie, et non la température, est la principale variable d’état thermodynamique d’un système isolé (voir Sec. IID).

The debate has revealed some widespread misconceptions about the general meaning of temperature in isolated systems. For example, it is often claimed [10–12] that knowledge of the microcanonical temperatures suffices to predict the direction of heat flow. This statement, which is frequently mistaken as being equivalent to the second law, is true in many situations, but not in general, reflecting the fact that energy, not temperature, is the primary thermodynamic state variable of an isolated system (see Sec. IID).

Source :

Hilbert, S., P. Hänggi, and J. Dunkel (2014). Thermodynamic laws in isolated systems. Physical Review E 90, 062116

On a fait remarquer plus haut qu’il n’y a qu’un seul parcours physiquement possible dans l’espace des phases d’un univers régi par des lois déterministes. Cela signifie que si l’état de l’univers est connu avec une précision parfaite à tout moment, son état à tout autre moment peut être prédit avec certitude. En physique, cependant, lorsqu’on s’intéresse à l’univers dans son ensemble, on ne connaît jamais son état avec une précision parfaite, de sorte qu’il est représenté non pas par un point, mais par un volume fini de l’espace des phases. Lorsque l’on ne s’intéresse pas à l’univers dans son ensemble, mais à un sous-système ouvert de l’univers, on a encore implicitement affaire à des volumes finis d’espace de phase universel. Car l’état d’un sous-système ouvert de l’univers est une spécification partielle de l’état de l’univers dans son ensemble. Tout ce qui est plus grand qu’un volume ponctuel dans l’espace des phases d’un tel système correspond à un volume fini dans l’espace des phases universel (étendu dans toutes les dimensions qui lui sont extérieures). Lorsque l’on a affaire à des volumes finis de l’espace des phases, même dans un univers régi par des lois déterministes, on n’est plus dans une situation où il n’y a qu’une seule trajectoire à partir du point de départ. Il y a de multiples trajectoires – typiquement, un nombre infini – qui partent de n’importe quel volume fini de l’espace des phases. Et les lois dynamiques qui ne limitent que les possibilités – même les lois déterministes qui ne donnent qu’une seule possibilité pour chaque point de l’espace des phases – sont impuissantes à faire la distinction entre les possibilités. Elles nous diront quelles trajectoires sont possibles, mais resteront muettes sur la manière de répartir l’opinion entre elles.

En pratique, lorsque l’on réalise, par exemple, une expérience sur un système localisé dans un laboratoire, on peut ignorer la possibilité qu’une comète arrive à la vitesse de la lumière et détruise l’appareil, que l’air de la pièce s’accumule de manière anti-thermodynamique dans un coin, ou que l’aiguille de notre appareil de mesure soit perturbée par un événement de tunnel quantique, même s’il existe des modèles de lois physiques dans lesquels chacun de ces événements se produit, car ces possibilités ont une probabilité négligeable ou faible. En tant que possibilités, elles sont au même niveau que celles que nous prenons au sérieux (par exemple, que le résultat que nous avons observé nous dit quelque chose sur le système que nous mesurons). La symétrie épistémique n’est rompue que par la probabilité relative. Il ne sert à rien de dire que de nombreux sous-systèmes ouverts sont approximativement fermés, car les probabilités sont nécessaires pour déterminer les degrés de fermeture. Dire qu’un système est approximativement fermé revient à dire que la probabilité d’une influence extérieure est minimisée.

It was remarked above that there is only one physically possible trajectory through the phase space of a universe governed by deterministic laws. This means that if the state of the universe is known with perfect precision at any time, its state at any other can be predicted with cer tainty. In physics, however, when one is interested in the universe as a whole, one never knows its state with perfect precision, so it is represented not with a point, but with a finite volume of phase space. When one is not interested in the universe as a whole, but in an open sub-system of the universe, one is still dealing implicitly with finite volumes of universal phase space. For the state of an open subsystem of the universe is a partial specification of the state of the universe as a whole. Anything larger than a point-sized volume in the phase space of such a system corresponds to a finite volume in the universal phase space (extended in all dimensions external to it). When one is dealing with finite volumes of phase space, even in a universe governed by deterministic laws, one is no longer in a situation in which there is a single trajectory leading from one’s starting point. There are multiple trajectories – typically, an infinite number – coming out of any finite volume of phase space. And dynamical laws that constrain only possibility – even deterministic laws that yield a single possibility for every point in phase space – are impotent to discriminate between possibilities. They will tell us which trajectories are possible, but will be silent about how to divide opinion among them.

In practice, when one is, for example, carrying out an experiment on some localized system in the lab, one can ignore the possibility that a comet will come at light speed and destroy the apparatus, that the air in the room will anti-thermodynamically collect in one corner, or that the pointer on our measuring device will be disturbed by a quantum tunnel ing event, even though there are models of the physical laws in which each of these occurs, because these possibilities have negligible or low probability. As possibility goes, they are on a par with those we take seriously (for example, that the result we observed tells us something about the system we are measuring). The epistemic symmetry is broken only by relative probability. It does not help to say there that many open subsystems are approximately closed, for probabilities are needed to make out degrees of closure. To say that a system is approximately closed is to say that the probability of outside influence is minimized.

Source :

Ismael, J. T. (2009). Probability in Deterministic Physics. The Journal of Philosophy, 106(2), 89–108. http://www.jstor.org/stable/20620154

Le forage sg3, forage profond de Kola (Кольская сверхглубокая скважина en russe) ou encore forage de Zapoliarny, du nom de la ville la plus proche, ou de son nom officiel le puits de référence superprofond expérimental de Kola (SG-3), est un forage effectué à partir du 24 mai 1970 et jusqu’en 1989 en Russie, dans la péninsule de Kola.

Ce forage est le forage le plus profond du monde (profondeur verticale réelle). En longueur totale, il a toutefois été dépassé en 2008 par le puits de pétrole Al Shaheen mesurant 12 289 mètres de long (40 318 pieds) au Qatar, et en 2011, par le puits Sakhaline I Odoptu OP-11 mesurant 12 345 mètres de long (au large de l’île russe de Sakhaline).

Défi énergie #5

La substitution des énergies serait possible si les sociétés thermo-industrielles constituaient des systèmes physiques ouverts sur l’énergie provenant du vent, du rayonnement solaire ou de l’énergie atomique.

INDIQUEZ LES SOLUTIONS ➤

Les critères choisis afin de définir les systèmes concernés par l’ambition de transition énergétique définissent différents types d’interaction entre ces systèmes et leur milieu.

Un système thermo-industriel est un système ouvert sur l’énergie provenant des hydrocarbures, parce que cette énergie est un flux d’entropie autorisant l’organisation de ces systèmes. En revanche, d’éventuelles sociétés éolo/photo/nucléo-industrielles, indépendantes des sociétés thermo-industrielles ne seraient pas, par elles-mêmes, des sociétés ouvertes sur les énergies que les ENS convertissent. Ces énergies ne contribueraient pas, en l’état des connaissances, par leur seule présence associée à la force de travail et à l’intelligence humaines, à l’organisation de ces sociétés. Les ENS ne peuvent générer de l’énergie utilisable par les sociétés thermo-industrielles qu’à la condition que ces sociétés disposent d’authentiques sources d’énergie, dont l’exploitation autorise l’amorce et l’entretien de différents processus industriels, dont ceux indispensables aux ENS.

De plus, le fait que la planète Terre, en tant que système physique, soit un système ouvert sur l’énergie du Soleil ne fait pas des sociétés thermo-industrielles des systèmes ouverts sur autre chose que leurs sources d’énergie, bien que les sociétés thermo-industrielles fassent partie du système Terre. Les frontières de ces systèmes ne sont pas superposables, et ça n’est pas la Terre qui doit effectuer une transition énergétique, ce sont les sociétés thermo-industrielles.

Sources

Pages 186 à 189 de “Qu’est-ce que la vie ?” :

En biologie, nous nous trouvons en face d’une situation entièrement différente. Un seul groupe d’atomes n’existant qu’en un seul exemplaire produit des événements ordonnés et merveilleusement harmonisés l’un avec l’autre ainsi qu’avec le milieu environnant, et cela grâce à des lois extraordinairement subtiles. J’ai dit qu’il n’existait qu’en un seul exemplaire, car, somme toute, nous avons l’exemple de l’œuf et de l’organisme unicellulaire. Au cours des stades suivants d’un organisme supérieur, les exemplaires sont multipliés, il est vrai. Mais jusqu’à quel point ? Si je ne m’abuse, quelque chose comme 1014 chez un mammifère adulte. Qu’est-ce cela ? Moins d’un millionième du nombre de molécules se trouvant dans un centimètre cube d’air. Quoique nos groupes d’atomes soient bien plus volumineux que les molécules d’air, ils ne forment en se soudant intimement qu’une seule petite goutte de liquide. Et notez la façon dont ils sont réellement répartis. Chaque cellule contient tout juste un seul d’entre eux, ou deux si nous tenons compte de la diploïde. Sachant quelle puissance ces minuscules bureaux centraux exercent dans les cellules isolées, ne font-elles pas penser à des sièges de gouvernement local, répartis au travers du corps et communiquant aisément l’un avec l’autre, grâce au code qui leur est commun à tous ?

Cela peut sembler être une description fantastique, convenant peut-être moins à un savant qu’à un poète. Pourtant il n’est nul besoin d’imagination poétique mais seulement de réflexion scientifique, claire et nette, pour reconnaître que nous nous trouvons évidemment en face d’événements dont le développement régulier et bien ordonné est dirigé par un « mécanisme » entièrement différent du « mécanisme de probabilité » de la physique. Car c’est simplement un fait d’observation que le principe directeur contenu dans chaque cellule est incorporé en une seule association atomique n’existant qu’en un seul exemplaire, ou parfois deux, et c’est encore un fait d’observation que le résultat est la production d’événements qui sont un modèle d’ordre. Que nous soyons stupéfaits ou que nous trouvions tout à fait plausible de constater qu’un petit groupe d’atomes, supérieurement organisé, puisse se comporter de cette manière, la situation est sans précédent : elle n’est rencontrée que dans la matière vivante. Le physicien et le chimiste, en explorant la matière inanimée, n’ont jamais été témoins de phénomènes qu’il leur fallût interpréter de cette façon. Le cas ne s’étant pas présenté, n’a pas été prévu par notre théorie – notre magnifique théorie statistique ! Nous en étions justement si fiers parce qu’elle nous permettait de voir derrière le rideau et d’être témoins de l’ordre magnifique des lois physiques exactes sortant du désordre atomique et moléculaire, et aussi qu’elle nous a révélé que la loi de l’accroissement d’entropie, la plus importante, la plus générale de toutes, pourrait être comprise sans le secours d’hypothèses spéciales car elle n’exprime rien d’autre que le désordre moléculaire lui-même.

65. Deux méthodes de production d’ordre.

L’ordre constaté dans le développement de la vie vient d’une source différente. Il semble qu’il y ait deux « mécanismes » différents qui permettent la production d’événements ordonnés, le « mécanisme statistique » qui produit de « l’ordre à partir du désordre » et la méthode nouvelle, créatrice « d’ordre à partir d’ordre ». Pour l’esprit sans préjugés, le second principe paraît être beaucoup plus simple, beaucoup plus plausible. Il l’est certainement. C’est pourquoi les physiciens étaient si fiers d’avoir découvert l’autre, le principe de « l’ordre à partir du désordre », qui est réellement suivi par la nature et qui seul permet la compréhension de la suite des événements naturels, et en premier lieu de leur irréversibilité. Mais nous ne pouvons nous attendre à ce que les « lois de la physique » qui en sont dérivées puissent suffire directement à expliquer le comportement de la matière vivante dont les caractères les plus frappants sont visiblement basés, en grande partie, sur le principe de « l’ordre par l’ordre ». On ne peut espérer que deux mécanismes entièrement distincts puissent correspondre au même type de loi – de même que vous ne pouvez vous attendre à ce que votre clef de sûreté ouvre aussi la porte de votre voisin.

Source :

Erwin Schrödinger, Qu’est-ce que la vie ? De la physique à la biologie, Points sciences, 1993.

Texte original :

“What is Life?: With Mind and Matter and Autobiographical Sketches”, pages 79 et 80 :

In biology we are faced with an entirely different situation. A single group of atoms existing only in one copy produces orderly events, marvellously tuned in with each other and with the environment according to most subtle laws. I said, existing only in one copy, for after all we have the example of the egg and of the unicellular organism. In the following stages of a higher organism the copies are multiplied, that is true. But to what extent? Something like 1014 in a grown mammal, I understand. What is that! Only a millionth of the number of molecules in one cubic inch of air. Though comparatively bulky, by coalescing they would form but a tiny drop of liquid. And look at the way they are actually distributed. Every cell harbours just one of them (or two, ifwe bear in mind diploidy). Since we know the power this tiny central office has in the isolated cell, do they not resemble stations of local government dispersed through the body, communicating with each other with great ease, thanks to the code that is common to all of them?

Well, this is a fantastic description, perhaps less becoming a scientist than a poet. However, it needs no poetical imagination but only clear and sober scientific reflection to recognize that we are here obviously faced with events whose regular and lawful unfolding is guided by a ‘mechanism’ entirely different from the ‘probability mechanism’ of physics. For it is simply a fact of observation that the guiding principle in every cell is embodied in a single atomic association existing only in one copy (or sometimes two) – and a fact ofobservation that it results in producing events which are a paragon oforderliness. Whether we find it astonishing or whether we find it quite plausible that a small but highly organized group of atoms be capable of acting in this manner, the situation is unprecedented, it is unknown anywhere else except in living matter. The physicist and the chemist, investigating inanimate matter, have never witnessed phenomena which they had to interpret in this way. The case did not arise and so our theory does not cover it – our beautiful statistical theory of which we were so justly proud because it allowed us to look behind the curtain, to watch the magnificent order of exact physical law coming forth from atomic and molecular disorder; because it revealed that the most important, the most general, the all-embracing law of entropy increase could be understood without a special assumption ad hoc, for it is nothing but molecular disorder itself.

TWO WAYS OF PRODUCING ORDERLINESS

The orderliness encountered in the unfolding of life springs from a different source. It appears that there are two different ‘mechanisms’ by which orderly events can be produced: the ‘statistical mechanism’ which produces ‘order from disorder’ and the new one, producing ‘order from order’. To the unprejudiced mind the second principle appears to be much simpler, much more plausible. No doubt it is. That is why physicists were so proud to have fallen in with the other one, the ‘order-from-disorder’ principle, which is actually followed in Nature and which alone conveys an understanding of the great line of natural events, in the first place of their irreversibility. But we cannot expect that the ‘laws of physics’ derived from it suffice straightaway to explain the behaviour of living matter, whose most striking features are visibly based to a large extent on the ‘order-from-order’ principle. You would not expect two entirely different mechanisms to bring about the same type of law – you would not expect your latch-key to open your neighbour’s door as well.

Source :

Schrödinger, E., & Penrose, R. (1992). What is Life?: With Mind and Matter and Autobiographical Sketches (Canto). Cambridge: Cambridge University Press. doi:10.1017/CBO9781139644129

L’ambition de transition énergétique fondée sur l’exploitation de l’énergie du vent, du rayonnement solaire ou des atomes, par l’intermédiaire des ENS, n’est pas en mesure d’ouvrir les sociétés humaines sur des flux organisateurs susceptibles de se substituer à ceux provenant de la biomasse ou des hydrocarbures.

Sans source d’énergie, les sociétés thermo-industrielles sont condamnées à consommer leur propre énergie interne (celle convertie par leurs ENS). Leur complexité est condamnée à se réduire, leur entropie à augmenter, jusqu’à l’équilibre thermodynamique (voir : Dissipation d’énergie et organisation).

La transition énergétique fondée sur le déploiement des ENS équivaudrait à convertir l’industrie des sociétés thermo-industrielles en mouvement perpétuel : des systèmes censés entretenir leur propre mouvement uniquement à partir de leur énergie interne. La possibilité du mouvement perpétuel a été réfutée de longue date.

Sources

Pour créer de l’énergie, il faudrait qu’un mouvement perpétuel produise également une accélération perpétuelle de son mouvement, ce sans quoi il ne peut être source d’autre énergie que celle de son propre mouvement.

Wikipédia“L’Académie a pris, cette année, la résolution de ne plus examiner […] aucune machine annoncée comme un mouvement perpétuel. La construction d’un mouvement perpétuel est absolument impossible. […] En faisant abstraction du frottement et de la résistance, un corps à qui on a une fois imprimé un mouvement le conserverait toujours ; mais c’est en n’agissant point sur d’autres corps, et le seul mouvement perpétuel possible, dans cette hypothèse (qui d’ailleurs ne peut avoir lieu dans la Nature) serait absolument inutile à l’objet que se proposent les Constructeurs des mouvements perpétuels. Ce genre de recherche a l’inconvénient d’être coûteux, il a ruiné plus d’une famille, et souvent les Mécaniciens qui eussent pu rendre de grands services y ont consumé leur fortune, leur temps et leur génie.”

Source :

Registre de l’Académie royale des sciences. 1775. Consultable sur le site Gallica.

Source :

Enregistrement audio des conférences de Feynman sur la physique, conférence 4, 6 octobre 1961

Page 151 de “Irreversibility; or, entropy since 1905” :

L’irréversibilité ou l’entropie depuis 1905

1 Afin d’éviter les malentendus qui pourraient survenir, je tiens à préciser d’emblée que je n’ai pas l’intention, dans cette note, de suggérer que la seconde loi de la thermodynamique est en fait fausse. Ce que je souhaite suggérer, c’est que la situation logique liée à la loi de l’entropie (que j’appellerai ici “deuxième loi de la thermodynamique”) est très insatisfaisante, et qu’il en est ainsi depuis 1905.

Planck l’a formulée en analogie avec la formulation suivante de la “première loi” qui, comme on le sait, peut être formulée comme la “loi de la machine à mouvement perpétuel exclue du premier ordre” :

(I) Il n’existe pas de machine à mouvement perpétuel du premier ordre, c’est-à-dire un système physique fermé qui pompe constamment de la chaleur dans son environnement physique ou qui absorbe constamment de la chaleur de son environnement physique.

Par analogie, la loi de l’entropie (deuxième loi) peut être formulée comme suit :

(II) Il n’existe pas de machine à mouvement perpétuel, du deuxième ordre, c’est-à-dire un système physique, immergé dans un bain de chaleur, qui, en se refroidissant (ou, ce qui revient au même, en absorbant de la chaleur du bain de chaleur environnant), peut déplacer un corps lourd contre une force, augmentant ainsi son énergie potentielle ; ou, en termes terrestres, une machine qui, en se refroidissant, peut soulever un poids.

Je ne sais pas s’il existe une meilleure formulation phénoménologique de la loi de l’entropie.

Irreversibility; or, Entropy since 1905

1 To avoid misunderstandings which might arise otherwise, I wish to make clear at the outset that I do not intend, in this note, to suggest that the second law of thermodynamics is in fact false. What I wish to suggest is that the logical situation in connection with the entropy law (as I shall here call the ‘second law of thermodynamics’) is highly unsatisfactory, and that it has been so ever since 1905.

That the law is in need of a kind of phenomenological formulation had been realised long before that date; and Planck formulated it in analogy to the following formulation of the ‘first law’ which, as is well known, can be formulated as the ‘law of the excluded perpetual motion machine of the first order’ :

(I) There does not exist a perpetual motion machine of the first order; that is to say, an otherwise closed physical system which either constantly pumps heat into its physical environment, or which constantly absorbs heat from its physical environment.

The entropy law (second law) may be formulated by analogy, as follows:

(II) There does not exist a perpetual motion machine, of the second order, that is to say, a physical system, immersed in a heat bath, which, by cooling down (or, which is the same, by absorbing heat from the surrounding heat bath), can move a heavy body against a force, thus increasing its potential energy; or in terrestrial terms, a machine which, by cooling down, can lift a weight.

I am not aware that a better phenomenological formulation of the entropy law exists.

Source :

Popper, Karl R. (1957). Irreversibility; or, entropy since 1905. British Journal for the Philosophy of Science 8 (30):151-155.

Article “Thermodynamic laws in isolated systems”

Source :

Hilbert, S., P. Hänggi, and J. Dunkel (2014). Thermodynamic laws in isolated systems. Physical Review E 90, 062116

Source :

Pierre Duhem, Les Origines de la statique, t. tome premier, Paris, Librairie Scientifique A. Herrmann, 1905

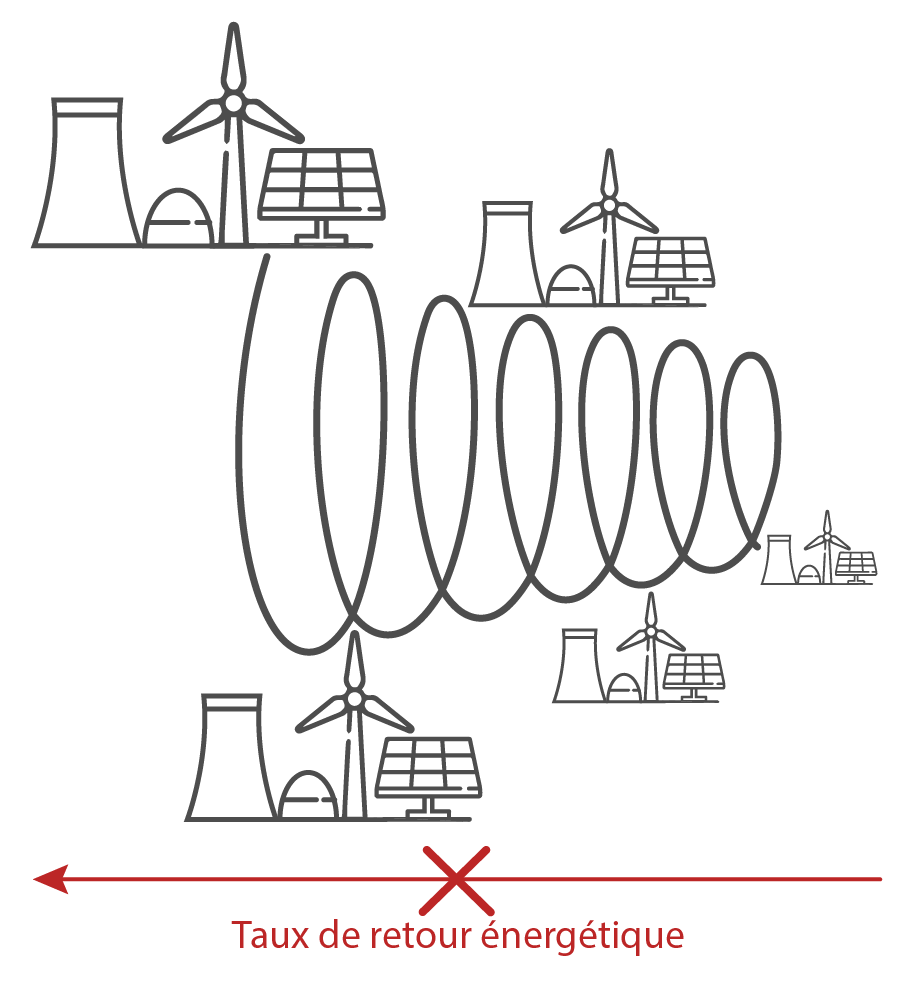

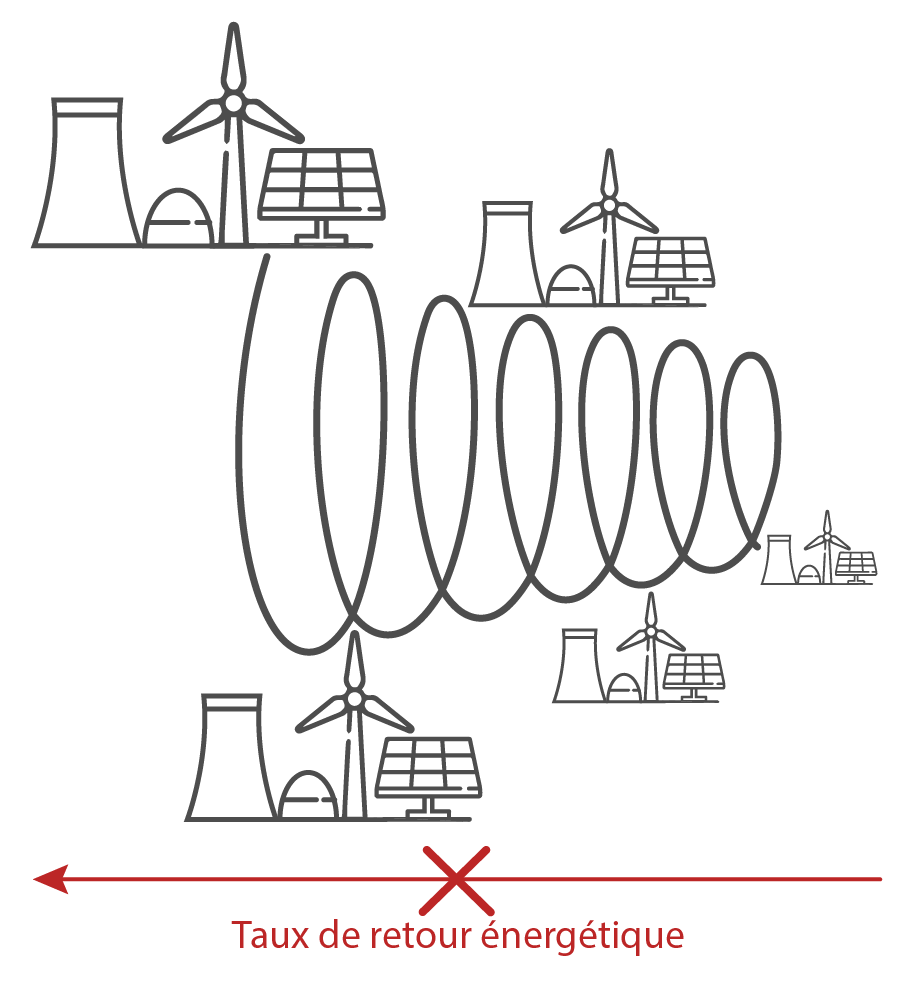

Le taux de retour énergétique (TRE, ou EROEI pour Energy Returned On Energy Invested) évalue le rapport entre une unité d’énergie investie pour obtenir de l’énergie, et l’énergie obtenue en retour (énergie nette = quantité d’énergie que les sociétés peuvent utiliser pour d’autres services que l’exploitation de l’énergie). Cet indicateur ne donne aucune information sur la capacité de l’énergie nette à contribuer à l’organisation des sociétés humaines.

Selon les connaissances en physique de l’énergie (voir la page : Comprendre l’énergie), stabiliser le niveau d’organisation (ou d’entropie) des sociétés humaines implique une augmentation de l’entropie du milieu duquel elles extraient leur flux organisateur. Or, les études sur le TRE des sociétés humaines ne paraissent pas tenir compte de l’impact du “prélèvement d’entropie” sur le milieu d’où cette entropie provient, ou sur les infrastructures qui permettent de l’extraire de ce milieu. Les études au moyen du TRE ne distinguent pas les différentes formes d’énergie ni leur origine, ou, si elles tiennent compte de ces distinctions, estiment que forme et origine ne constituent aucune contrainte au déploiement, à l’entretien et au remplacement en fin de vie des ENS.

Dans l’ambition d’une transition énergétique, il paraît nécessaire de considérer que tout prélèvement d’énergie, dans un but organisateur, sur les flux provenant des ENS augmente l’entropie de ces infrastructures, contribue à leur dégradation et exerce une pression sur les capacités de ces ENS à générer un flux d’énergie. En particulier, si les besoins en énergie augmentent avec le temps, parce que la maintenance, puis le remplacement des ENS, ou de toute machine dont la société thermo-industrielle dépend, exigent un apport d’énergie croissant avec le temps, alors l’énergie nette issue des ENS ne peut que décroître avec le temps, dès les premiers besoins en maintenance.

Sources

Source :

Feynman, R. 1983. Tiny Computers Obeying Quantum Mechanical Laws. Talk delivered at Los Alamos National Laboratory. Published in New Directions in Physics: The Los Alamos 40th Anniversary Volume. 1987. Edited by N. Metropolis, D. M. Kerr, and G.-C. Rota. Orlando, FL: Academic Press, Inc.

Étude “When is EROI Not EROI?”

Source :

Carbajales-Dale, M. When is EROI Not EROI?. Biophys Econ Resour Qual 4, 16 (2019). https://doi.org/10.1007/s41247-019-0065-8

Étude “Comparing Apples to Apples: Why the Net Energy Analysis Community Needs to Adopt the Life-Cycle Analysis Framework”

Source :

Murphy, David & Carbajales-Dale, Michael & Moeller, Devin. (2016). Comparing Apples to Apples: Why the Net Energy Analysis Community Needs to Adopt the Life-Cycle Analysis Framework. Energies. 9. 10.3390/en9110917.

Défi énergie #6

La substitution des énergies serait possible si l’irréversibilité de la dégradation du fonctionnement des machines qui convertissent l'énergie n’impactait pas l'approvisionnement en énergie des sociétés thermo-industrielles.

INDIQUEZ LES SOLUTIONS ➤

Défi énergie #7

La substitution des énergies serait possible si l’énergie nette des ENS, en fonction de leur taux de retour énergétique (TRE), équivalait à un flux d’énergie susceptible de maintenir l'organisation des sociétés thermo-industrielles (flux organisateur).

INDIQUEZ LES SOLUTIONS ➤

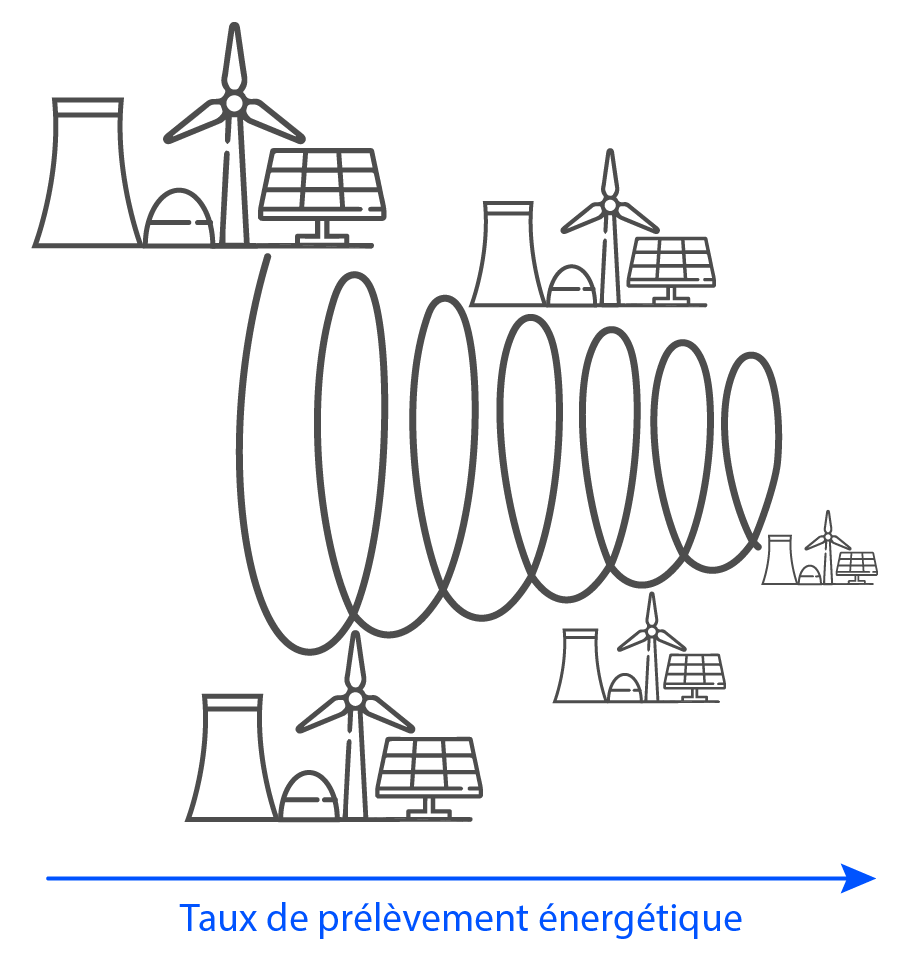

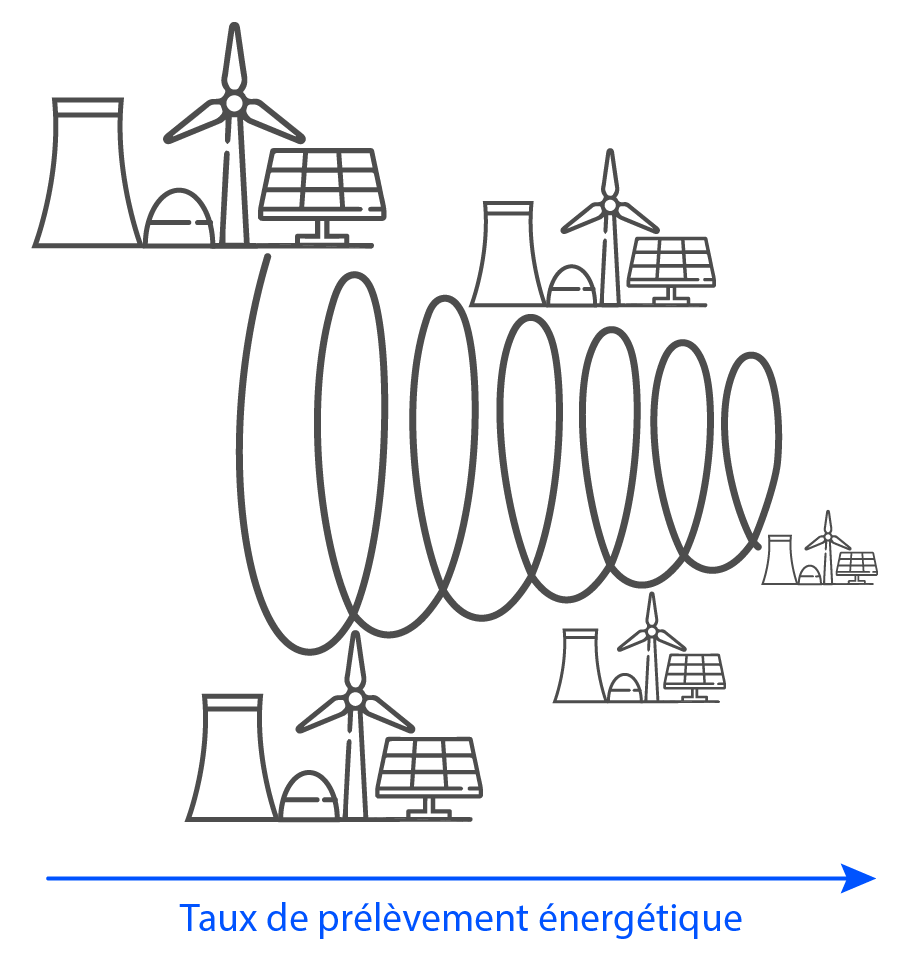

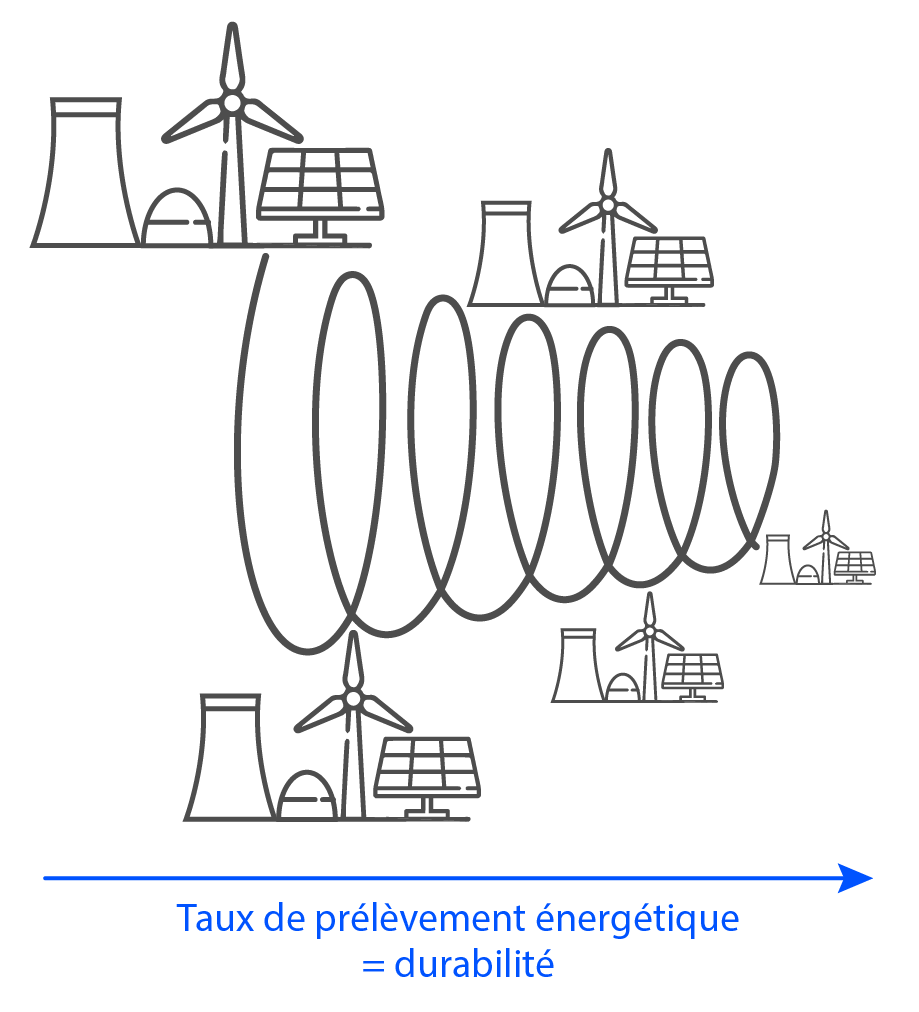

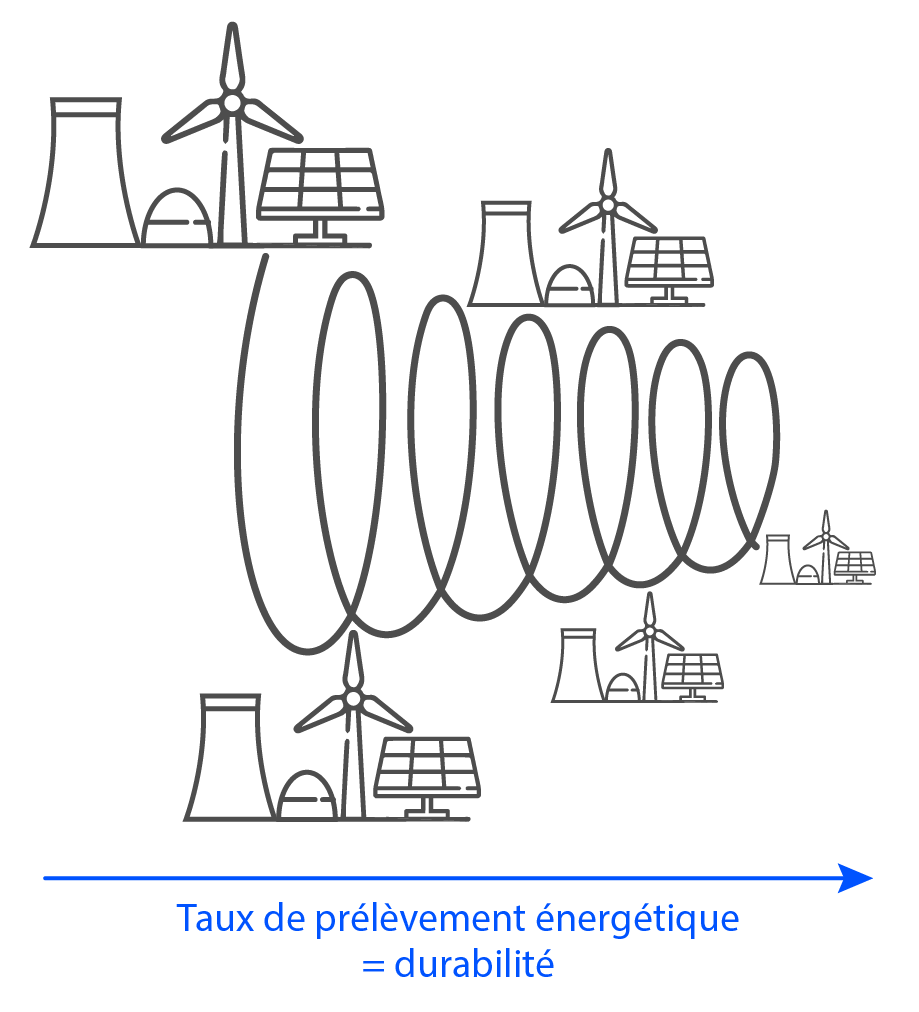

Selon les conditions nécessaires à l’existence et à la stabilisation de toute structure dissipative, dont font partie les sociétés thermo-industrielles, l’estimation de la réalisabilité d’une transition énergétique relèverait moins du calcul d’un taux de retour énergétique, que du calcul d’un taux de prélèvement énergétique (TPE ou EWR pour Energy Withdrawal Rate).

Un taux de prélèvement énergétique établirait le rapport entre la quantité d’énergie dont a besoin un système pour s’organiser (flux organisateur), et l’effet sur le niveau d’entropie des systèmes physiques depuis lesquels est extraite cette énergie, c’est-à-dire l’effet sur leur capacité à satisfaire cet apport d’énergie dans le temps.

Un TPE pourrait être :

- Plus ou moins supérieur à 0, lorsque le prélèvement augmenterait, par défaut, l’entropie des systèmes depuis lesquels l’énergie est extraite

- Nul, lorsque le prélèvement n’impacterait pas le niveau d’entropie de ces systèmes

Un TPE évaluerait dans quelle mesure la nature même de l’énergie prélevée influencerait l’évolution du système physique considéré : si cette énergie n’est pas une source, si elle n’est pas un flux organisateur, si elle est une énergie interne au système, alors, par défaut, le TPE serait intrinsèquement supérieur à 0, à cause de l’impossibilité de renouvellement des moyens permettant l’exploitation de l’énergie considérée. Dans ces conditions, le système ne pourra évoluer que vers la dégradation de son organisation.

Sources

Source :

Richard P. Feynman, Robert B. Leighton, Matthew Sands, The Feynman Lectures on Physics, Addison-Wesley, 1970.

Pages 50 à 54 de “The Evolution of Physics” :

Il y a moins de cent ans, le nouvel indice qui a conduit au concept de la chaleur comme forme d’énergie a été deviné par Mayer et confirmé expérimentalement par Joule. C’est une étrange coïncidence que presque tous les travaux fondamentaux concernant la nature de la chaleur aient été réalisés par des physiciens non professionnels qui considéraient la physique comme un simple passe-temps. Il y avait l’Écossais polyvalent Black, le médecin allemand Mayer et le grand aventurier américain Count Rumford, qui a ensuite vécu en Europe et est devenu, entre autres, ministre de la guerre de Bavière. Il y avait aussi le brasseur anglais Joule qui, pendant son temps libre, a réalisé des expériences très importantes sur la conservation de l’énergie.

Joule a vérifié par l’expérience l’hypothèse selon laquelle la chaleur est une forme d’énergie et a déterminé le taux de change. Il vaut la peine de voir quels ont été ses résultats.

L’énergie cinétique et l’énergie potentielle d’un système constituent ensemble son énergie mécanique. Dans le cas de l’aiguillage, nous avons supposé qu’une partie de l’énergie mécanique était convertie en chaleur. Si cela est vrai, il doit y avoir ici et dans tous les autres processus physiques similaires un taux de change défini entre les deux. Il s’agit rigoureusement d’une question quantitative, mais le fait qu’une quantité donnée d’énergie mécanique puisse être transformée en une quantité définie de chaleur est extrêmement important. Nous aimerions savoir quel nombre exprime le taux de change, c’est-à-dire la quantité de chaleur que nous obtenons à partir d’une quantité donnée d’énergie mécanique.

(…)

Une fois ce travail important accompli, les progrès ont été rapides. Il fut rapidement reconnu que ces types d’énergie, mécanique et thermique, ne sont que deux de ses nombreuses formes. Tout ce qui peut être converti en l’une ou l’autre de ces formes d’énergie est également une forme d’énergie. Le rayonnement du soleil est de l’énergie, car une partie est transformée en chaleur sur la terre. Un courant électrique possède de l’énergie, car il chauffe un fil ou fait tourner les roues d’un moteur. Le charbon représente de l’énergie chimique, libérée sous forme de chaleur lorsque le charbon brûle. Dans chaque événement de la nature, une forme d’énergie est convertie en une autre, toujours à un taux de change bien défini. Dans un système fermé, isolé des influences extérieures, l’énergie est conservée et se comporte donc comme une substance. La somme de toutes les formes d’énergie possibles dans un tel système est constante, même si la quantité de l’une d’entre elles peut varier. Si nous considérons l’univers entier comme un système fermé, nous pouvons fièrement annoncer, avec les physiciens du XIXe siècle, que l’énergie de l’univers est invariante, qu’aucune partie ne peut jamais être créée ou détruite.

Pages 89 et 90 :

[Étude du fonctionnement d’une batterie]

Pour tenter de sauver la théorie des fluides, on peut supposer qu’une force constante agit pour régénérer la différence de potentiel et provoquer un écoulement de fluide électrique. Mais l’ensemble du phénomène est étonnant du point de vue de l’énergie. Une quantité notable de chaleur est générée dans le fil qui transporte le courant, suffisamment même pour faire fondre le fil s’il est fin. Il y a donc création d’énergie thermique dans le fil. Mais l’ensemble de la pile voltaïque forme un système isolé, puisqu’aucune énergie extérieure n’est fournie. Si nous voulons sauver la loi de conservation de l’énergie, nous devons trouver où les transformations ont lieu et à quel prix la chaleur est créée. Il n’est pas difficile de se rendre compte que des processus chimiques complexes ont lieu dans la pile, processus dans lesquels le cuivre et le zinc immergés, ainsi que le liquide lui-même, jouent un rôle actif. Du point de vue de l’énergie, voici la chaîne de transformations qui se produit : énergie chimique à énergie du fluide électrique qui circule, c’est-à-dire le courant à chaleur. Une pile voltaïque ne dure pas éternellement ; les changements chimiques associés au flux d’électricité rendent la pile inutilisable au bout d’un certain temps.

L’expérience qui a révélé les grandes difficultés d’application des idées de la mécanique doit sembler étrange à ceux qui l’entendent pour la première fois.

Less than a hundred years ago the new clue which led to the concept of heat as a form of energy was guessed by Mayer and confirmed experimentally by Joule. It is a strange coincidence that nearly all the fundamental work concerned with the nature of heat was done by non-professional physicists who regarded physics merely as their great hobby. There was the versatile Scotsman Black, the German physician Mayer, and the great American adventurer Count Rumford, who afterwards lived in Europe and, among other activities, became Minister of War for Bavaria. There was also the English brewer Joule who, in his spare time, performed some most important experiments concerning the conservation of energy.

Joule verified by experiment the guess that heat is a form of energy, and determined the rate of exchange. It is worth our while to see just what his results were.

The kinetic and potential energy of a system together constitute its mechanical energy. In the case of the switchback we made a guess that some of the mechanical energy was converted into heat. I f this is right, there must be here and in all other similar physical processes a definite rate o f exchange between the two. This is rigorously a quantitative question, but the fact that a given quantity of mechanical energy can be changed into a definite amount of heat is highly important. We should like to know what number expresses the rate of exchange, i.e., how much heat we obtain from a given amount of mechanical energy.

(…)

Once this important work was done, further progress was rapid. It was soon recognized that these kinds of energy, mechanical and heat, are only two of its many forms. Everything which can be converted into either of them is also a form of energy. The radiation given off by the sun is energy, for part of it is transformed into heat on the earth. An electric current possesses energy, for it heats a wire or turns the wheels of a motor. Coal represents chemical energy, liberated as heat when the coal burns. In every event in nature one form of energy is being converted into another, always at some well-defined rate of exchange. In a closed system, one isolated from external influences, the energy is conserved and thus behaves like a substance. The sum of all possible forms of energy in such a system is constant, although the amount of any one kind may be changing. I f we regard the whole universe as a closed system, we can proudly announce with the physicists of the nineteenth century that the energy of the universe is invariant, that no part of it can ever be created or destroyed.

Pages 89 et 90 :

In an attempt to save the fluid theory, we may assume that some constant force acts to regenerate the potential difference and cause a flow of electric fluid. But the whole phenomenon is astonishing from the standpoint of energy. A noticeable quantity of heat is generated in the wire carrying the current, even enough to melt the wire if it is a thin one. Therefore, heat-energy is created in the wire. But the whole voltaic battery forms an isolated system, since no external energy is being supplied. I f we want to save the law of conservation of energy we must find where the transformations take place, and at what expense the heat is created. It is not difficult to realize that complicated chemical processes are taking place in the battery, processes in which the immersed copper and zinc, as well as the liquid itself, take active parts. From the standpoint of energy this is the chain of transformations which are taking place: chemical energy->energy of the flowing electric fluid, i.e., the current->heat. A voltaic battery does not last for ever; the chemical changes associated with the flow of electricity make the battery useless after a time.

The experiment which actually revealed the great difficulties in applying the mechanical ideas must sound strange to anyone hearing about it for the first time.

Source :

Albert Einstein, The Evolution of physics, Touchstone, 1967

L’importance du principe d’ordre à partir de bruit nous semble soulignée, bien que de façon non explicite, par une démonstration due à W. R. Ashby [9], de l’impossibilité logique d’une auto-organisation absolue, c’est-à-dire dans un système fermé sans interaction avec son environnement.

Cet auteur, d’abord dans la ligne des précédents, commence par définir un état d’organisation par l’existence de contraintes entre les parts d’un système qui peuvent être mesurées à l’aide de probabilités conditionnelles. Dans ce cadre, un système auto-organisateur serait un système capable d’augmenter son degré de connectivité, de telle sorte que se multiplient les contraintes entre parties qui deviennent ainsi plus interdépendantes. Mais cette propriété n’est pas la plus intéressante, et Ashby la désigne du nom d’auto-connectivité, pour réserver le terme d’auto-organisation à une propriété plus fondamentale, qui concerne le fonctionnement d’un système et pas seulement sa structure. Il souligne le fait que si l’on veut classer des organisations en bonnes et mauvaises, ou meilleures et pires, on ne peut éviter de définir un but par rapport auquel ce classement est établi. Une organisation n’est bonne ou mauvaise que par rapport à son efficacité à accomplir ce qu’elle est censée accomplir. Autrement dit, la notion même d’organisation et de progrès dans l’organisation, ne peut pas être séparée de celles de fonctionnement et d’adaptations aux conditions imposées pour ce fonctionnement.

Un système auto-organisateur serait alors, dans son sens le plus absolu, un système capable de définir et de déterminer lui-même le but à atteindre, c’est-à-dire le critère par rapport à quoi son organisation est bonne ou mauvaise ; et de s’adapter de plus en plus, en modifiant les lois de son organisation, de façon à la rendre meilleure. En utilisant la terminologie de la théorie des ensembles, appliquée à une définition formelle de l’organisation d’une machine, Ashby montre qu’un tel système ne peut pas exister. En effet, une machine, ou un automate fini, est formellement définie de la façon la plus générale possible par un ensemble {E} d’états internes, et un ensemble {I} d’entrées (inputs). Le fonctionnement de la machine est la façon dont les entrées et les états internes à un instant donné déterminent les états internes à l’instant suivant ; c’est-à-dire qu’il peut être décrit par une application f, qui est la projection (mapping) de l’ensemble produit {I} x {E} dans {E}

Mais que sont en fait ces états internes de la machine dans sa totalité ? Si elle est constituée par des parts i, susceptibles chacune d’exister dans différents états de position, d’orientation ou d’énergie par rapport aux autres, alors, pour chaque part i, il existe un ensemble {Ti} d’états possibles. L’ensemble {E} de tous les états possibles de l’ensemble n’est que l’ensemble produit de tous les ensembles {Ti} de toutes les parts :

Ainsi un élément de {E} est-il une façon particulière de spécifier l’état de chacune des parts. Puisque c’est le résultat de la fonction f, cela signifie que l’organisation des parts est spécifiée par la projection f. “Si on change f, alors l’organisation change [9]”. Autrement dit, suivant les termes de Ashby, “toutes les organisations possibles entre les parts du système peuvent être mises en relation biunivoque avec l’ensemble de toutes les projections possibles de I × E dans E. Ainsi, organisation et projection (mapping) sont-elles deux façons de considérer la même chose : l’organisation étant observée par celui qui observe le système lui-même, et la projection étant enregistrée par la personne qui veut représenter le comportement du système dans un symbolisme mathématique ou autre [9]”.

Ainsi, contrairement à ce que nous avons vu chez les auteurs précédents, une distinction très nette est établie entre “auto-connectivité”, propriété qui entraîne l’augmentation du nombre de connections, et “auto-organisation”, qui veut dire changement des lois de la connectivité, soit changement de f, de telle sorte que le système soit plus adapté à ce qu’il fait. Dans ce cadre de définitions, l’auto-organisation au sens strict voudrait dire un ou des changements de la projection f, sans aucune intervention de l’environnement. Si c’était possible, cela voudrait dire que la projection f de {E} dans {E} se changerait elle-même comme conséquence de {E} seul. Mais ceci est absurde, car si on pouvait définir un tel changement de f comme conséquence de {E}, ce changement lui-même ne serait qu’une partie d’une autre loi de projection f′, qui, elle, serait constante. Cela voudrait dire que l’organisation n’est pas gouvernée par f mais par f’, mais en aucun cas qu’elle est changée. Pour avoir une projection f qui change vraiment, en tant que projection, on doit définir une fonction α(t) du temps, qui déterminera des changements de f à partir de l’extérieur de {E}.

En conséquence, les seuls changements qui puissent concerner l’organisation elle-même, — et ne pas être seulement des changements d’états du système, faisant partie d’une organisation qui, elle, ne changerait pas —, doivent être produits d’en dehors du système. Mais ceci est possible de deux façons différentes. Soit un programme précis, injecté dans le système par un programmeur, déterminera les changements de f ; soit ceux-ci seront déterminés encore de l’extérieur, mais par des facteurs aléatoires dans lesquels aucune loi préfigurant une organisation ne peut être établie, aucun pattern permettant de discerner un programme. Certes, des contraintes physiques empêchant le système d’atteindre et de rester dans un état d’équilibre lui permettront d’être sans cesse traversé par des flux d’énergie, grâce auxquels le bilan énergétique et entropique sera toujours conforme au deuxième principe sans empêcher pour autant une diminution globale de l’entropie du système, ainsi que nous l’avons vu au chapitre précédent. De ce point de vue, les rythmes cosmiques (saisons, marées, nycthémère…) peuvent être considérés comme une première source d’ordre, ou plus exactement d’inhomogénéité, provenant de l’environnement. Mais cette source est insuffisante pour rendre compte de la grande variété possible de systèmes différents, se développant et évoluant sous l’effet de contraintes identiques. C’est pourquoi les seuls autres effets possibles de l’environnement susceptibles de changer l’organisation du système sont les effets aléatoires, fluctuations imprévisibles dans les contraintes physiques. C’est à propos de tels systèmes qu’on parlera d’auto-organisation. Ceci est donc une autre façon de suggérer un principe d’ordre à partir de bruit dans la logique de systèmes auto-organisateurs. Pourtant, ce qui est requis de l’environnement pour organiser le système est au minimum une constance dans la loi de variation de f de telle sorte de déterminer par là-même, ne serait-ce que de façon implicite, les critères par rapport auxquels un état d’organisation sera plus ou moins adapté.

(…)

En attendant, Ashby, rencontrant le problème de l’énorme complexité de structure et de fonctions des cerveaux de mammifères, compte encore sur des mesures de quantités d’information pour la décrire [35]. C’est dans ce contexte que lui apparaît la nécessité d’un assez grand degré d’indétermination dans les connexions, — internes et avec l’environnement —, pour permettre des simplifications et rendre possible une adaptation du type de celles qui apparaissent comme les produits de l’évolution des espèces et de l’apprentissage individuel. “La possibilité d’adaptation dans un temps raisonnable dépend fondamentalement de la présence de simplifications 9. Des situations où les interactions sont incomplètes ou faibles se produisent très fréquemment dans notre environnement terrestre, et ce que nous savons nous suggère que le cerveau a été profondément modelé par l’évolution pour tirer avantage de cet état de fait. Ainsi, la méthode habituelle qui consiste à travailler à un projet principal par la réalisation d’une suite de sous-projets est une expression de cette adaptation [35]”.

En partant de points de vue différents, nous sommes donc conduits à cette même idée que la logique d’une organisation doit être fondée sur des interactions entre le système et l’environnement, telles que :

a) le premier ne puisse pas être conçu isolé du second ;

b) le processus d’organisation et d’adaptation dépend, au moins en partie, d’effets aléatoires, c’est-à-dire non programmés, de l’environnement sur le système.

L’expression, due à Von Foerster, “principe d’ordre à partir de bruit” nous semble exprimer cette idée de façon adéquate. Il nous reste à envisager comment il a été possible de lui donner un commencement de formulation mathématique.

Source :

Henri Atlan, L’organisation biologique et la théorie de l’information, Seuil, 2006.

Si le système n’est pas regardé comme complètement isolé, il est probable que l’expression rigoureusement exacte de son énergie interne devra dépendre de l’état des corps extérieurs.

Source :

Henri Poincaré, La Science et l’hypothèse, Flammarion, 2014.

Antonin Berthe résume, dans une note de revue de la littérature sur la transition énergétique, les hypothèses explorées par Timothy John Harry Crownshaw dans sa thèse :

Sources :

– Antonin Berthe, Doctorant sur l’étude de faisabilité de transitions énergétique, “Notes de revue de la littérature sur la transition énergétique”, STEEP, CNRS, Université de Grenoble Alpes, juin 2022, communication privée.

– Timothy John Harry Crownshaw, “Exploring the solution space for physical global energy system transformation using stochastic system dynamics modelling“, McGill University, 2021.

Défi énergie #8

La substitution des énergies serait possible si le prélèvement d’énergie dans le milieu, nécessaire à la stabilisation du fonctionnement des ENS, pouvait être satisfait par les ENS dès lors qu’elles bénéficient d’un TRE suffisant, indépendamment de toute source d’énergie.

INDIQUEZ LES SOLUTIONS ➤

Défi énergie #9

La substitution des énergies serait possible si le prélèvement d’énergie nécessaire à la stabilisation du fonctionnement des ENS n’exerçait pas de pression sur l’exploitation des sources d’énergie des sociétés thermo-industrielles (biomasse combustible, hydrocarbures).

INDIQUEZ LES SOLUTIONS ➤

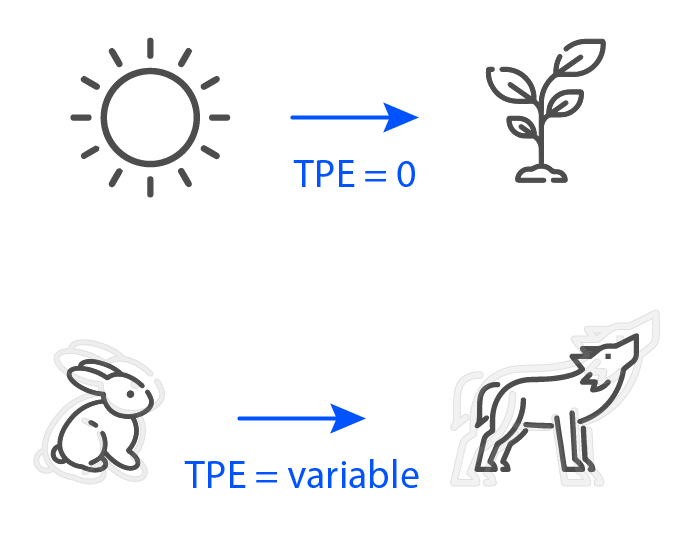

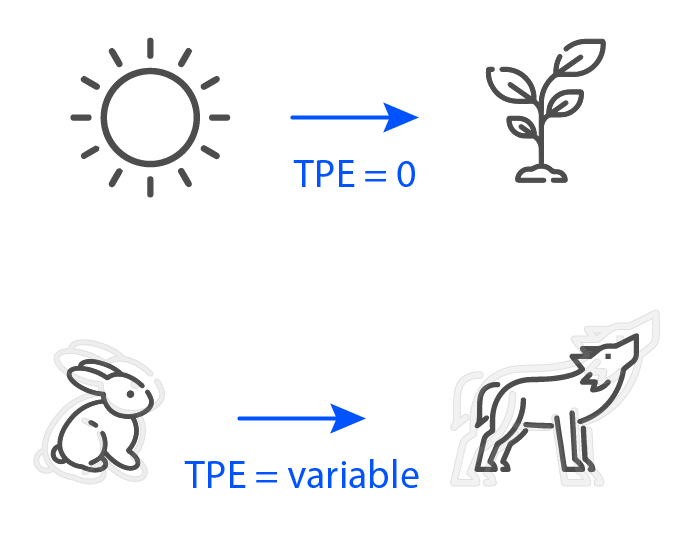

L’évaluation de la stabilité de l’organisation des structures dissipatives au moyen du taux de prélèvement énergétique (TPE) faciliterait certaines distinctions qualitatives entre ces systèmes, en fonction des interactions qu’ils établissent avec d’autres systèmes.

Par exemple, les végétaux sont capables de s’organiser à partir de l’énergie provenant du Soleil grâce à la photosynthèse. Ces végétaux sont dits autotrophes : ils ne dépendent pas d’autres êtres vivants pour leur approvisionnement en énergie, l’énergie du Soleil constitue leur source d’énergie vitale. Les organismes qui ne sont pas dotés de la capacité à la photosynthèse sont dits hétérotrophes : ils n’ont accès à l’énergie qu’en consommant d’autres êtres vivants. Pour les organismes hétérotrophes (dont l’espèce humaine fait partie), l’énergie provenant du Soleil constitue une source d’énergie vitale indirecte.

Le taux de prélèvement des organismes autotrophes dans leur ensemble pourrait être estimé nul par défaut : leur prélèvement n’a aucun impact sur la source d’énergie que constitue le Soleil. Les capacités du Soleil à générer de l’énergie ne sont pas affectées par l’existence des êtres vivants.

Le TPE des organismes hétérotrophes tiendrait compte des propriétés de la source d’énergie dans laquelle ils prélèvent de l’énergie afin de s’organiser : l’énergie reste disponible dans la mesure où les êtres vivants dont les organismes hétérotrophes se nourrissent conservent la capacité à s’organiser eux-mêmes et à se reproduire. Si le taux de prélèvement devient trop grand, au regard de la capacité à se renouveler des êtres vivants consommés par les organismes hétérotrophes, alors l’énergie sera d’autant moins disponible, et ceux-ci perdront de la capacité à maintenir leur propre organisation.

Différentes évolutions types du taux de prélèvement énergétique (TPE) peuvent être estimées, pour différents types de société, en fonction des caractéristiques de leurs approvisionnements en énergie.

- le TPE de sociétés humaines n’exploitant que la biomasse comestible serait nul si le prélèvement n’impactait aucunement le renouvellement de cette biomasse, et augmenterait en cas de perte de renouvelabilité de cette biomasse.

- le TPE de sociétés exploitant la biomasse combustible serait nul si le prélèvement n’impactait aucunement le renouvellement de cette biomasse, et augmenterait en cas de perte de renouvelabilité de cette biomasse.

- le TPE des sociétés exploitant les hydrocarbures (thermo-industrielles) serait intrinsèquement supérieur à 0, puisque les hydrocarbures ne peuvent pas se renouveler aux échelles de temps des besoins de ces sociétés, et son niveau évoluerait à la hausse ou à la baisse en fonction de la quantité d’énergie extraite de ces sources auxiliaires, déterminant la durabilité des sociétés thermo-industrielles. Un TPE égal à 0 pour l’exploitation des hydrocarbures interdirait l’existence de toute société thermo-industrielle.

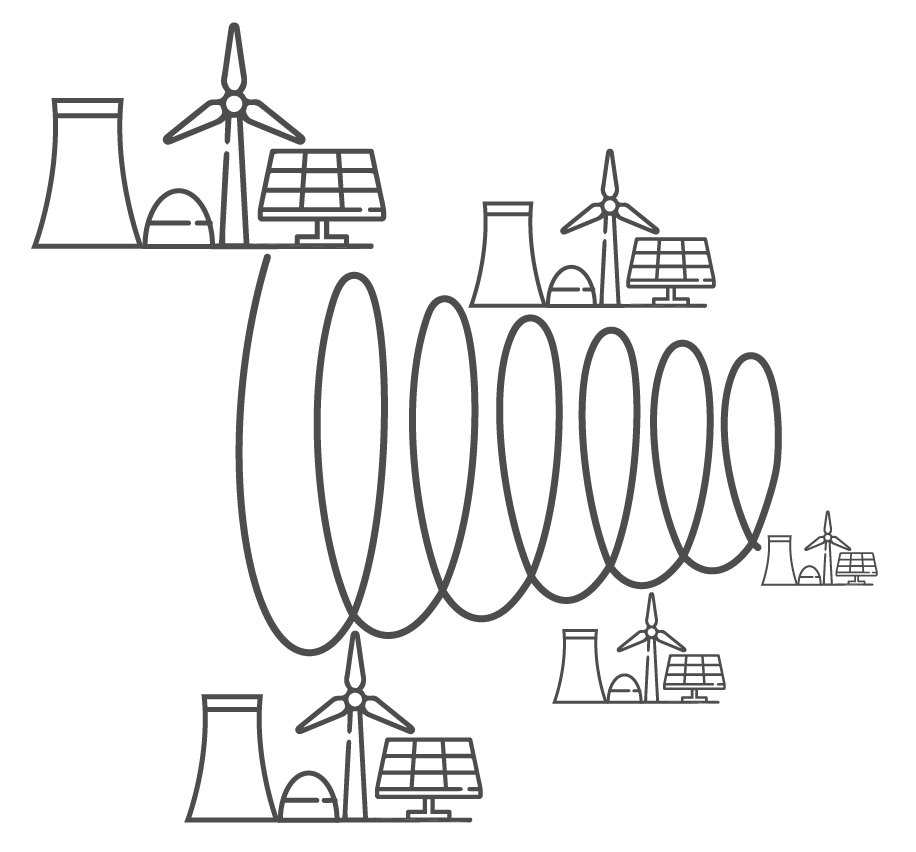

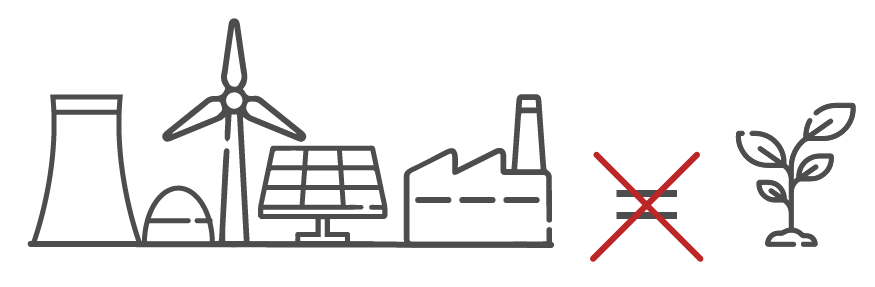

- le TPE de sociétés n’exploitant que l’énergie du vent, du rayonnement électromagnétique ou des atomes serait intrinsèquement supérieur à 0 et croissant, quel que soit le niveau de départ : les ENS ne sont pas dotées de capacités à l’auto-organisation et au renouvellement, les formes d’énergie auxquelles elles donnent accès ne sont pas des flux organisateurs, l’exploitation de ces énergies ne contribue alors pas à la stabilisation de l’organisation des ENS, et dégrade même progressivement leur fonctionnement.

Bien que les ENS, autant que l’ensemble des êtres vivants constituent des convertisseurs d’énergie, les ENS ne sont pas, pour les sociétés humaines, des sources d’énergie indirectes, comme le sont certains organismes vivants pour les organismes hétérotrophes. Les ENS sont incapables de se renouveler grâce à leurs propres capacités.

Sources

Page 440 de “Modern Thermodynamics. From Heat Engines to Dissipative Structures” :

Après avoir étudié quelques exemples de structures dissipatives, il est intéressant de les comparer avec des machines/ordinateurs ou des structures programmées (artificielles, au design spécifique], car il existe des différences fondamentales notables et intéressantes qui ont été judicieusement notées par Robert Rosen [34].

Tout d’abord, nous remarquons que la plupart des structures programmées sont basées sur une mécanique réversible dans le temps, classique ou quantique, c’est-à-dire que leur description mathématique est basée sur des processus dynamiques réversibles. La structure programmée idéale ne comprend pas de processus irréversibles ; pour obtenir les meilleures performances, les processus dissipatifs générateurs d’entropie doivent être réduits au minimum. En revanche, l’existence même des structures dissipatives dépend des processus dissipatifs. Leur description mathématique est basée sur des processus thermodynamiques irréversibles. Leur comportement n’est pas symétrique dans le temps.

Deuxièmement, la structure d’une structure programmée provient d’un processus externe au système, tout comme sa fonction : chaque structure conçue est destinée à remplir un ensemble spécifique de fonctions, tout comme ses composants. Dans les ordinateurs, “l’intelligence de la machine” est en fait une “intelligence empruntée” ; les algorithmes qui lui permettent de remplir sa fonction proviennent de processus extérieurs au système. Même si un ordinateur peut générer un algorithme, il ne peut le faire que parce qu’on lui a fourni un algorithme de niveau supérieur qui lui permet de le faire. En revanche, la structure des structures dissipatives provient de processus internes. Leur comportement, s’il peut être interprété comme une “fonction”, est entièrement une conséquence de l’auto-organisation. Dans une structure dissipative complexe, on peut associer des “fonctions” à divers sous-systèmes, mais ces fonctions sont entièrement autogénérées. Si l’on peut associer un “algorithme” à son comportement, celui-ci provient également de l’intérieur.

Enfin, la stabilité thermodynamique d’une structure dissipative signifie que les processus dissipatifs restaurent la structure si elle est perturbée ou “endommagée” – dans certaines limites, bien sûr. Cela leur confère la propriété d'”auto-guérison”. Ce n’est évidemment pas le cas des machines ou des ordinateurs.

Ces observations permettent de supposer que les structures dissipatives s’apparentent davantage à des organismes biologiques que les machines et les ordinateurs. Le paradigme de la machine n’est pas approprié en tant que théorie de l’organisme biologique. Cet aspect sera discuté plus en détail dans la conclusion du chapitre 21.

Having studied some examples of dissipative structures, it is interesting to compare them with machines/computers or designed structures, for there are some notable and interesting fundamental differences that have been insightfully noted by Robert Rosen [34].

First, we note that most designed structures are based on time-reversible mechanics, classical or quantum; i.e. their mathematical description is based on the reversible dynamical processes. The ideal designed structure does not include irreversible processes; for its best performance, entropy-generating dissipative processes must be minimized. In stark contrast, the very existence of dissipative structures depends on dissipative processes. Their mathematical description is based on irreversible thermodynamic processes. Their behavior is not time symmetric.

Second, the structure of a designed structure originates from a processes external to the system and so is its function: every designed structure is designed to perform a specific set of functions, as are its components. In computers, ‘machine intelligence’ is, in fact, ‘borrowed intelligence’; the algorithms that enable it to perform its function originate in processes external to the system. Even if a computer can generate an algorithm, it can do so only because it has been supplied with a higher-level algorithm that enables it to do so. In contrast, the structure in dissipative structures originates from processes within.Their behavior, if it could be interpreted as a ‘function’, is entirely a consequences of self-organization. In a complex dissipative structure, one may associate ‘functions’ to various subsystems, but those functions are entirely self-generated. If one could associate an ‘algorithm’ for its behavior, that too originates from within.

Finally, thermodynamic stability of dissipative structure means dissipative processes restore the structure if it is perturbed or ‘damaged’ – within bounds, of course. This bestows them with the property of ‘self-healing’. This is clearly not the case with machines or computers.

From these observations, one may surmise that dissipative structures are more akin to biological organisms than are machines and computers. The machine paradigm is inappropriate as a theory of biological organism. This aspect will be discussed further in the concluding Chapter 21.

Source :

Ilya Prigogine, Dilip Kondepudi, Modern Thermodynamics. From Heat Engines to Dissipative Structures, Odile Jacob, 1999.

(…)

Définitions qualitatives

(…)

Le propre d’un système microscopique organisé, ou système organisé naturel tel qu’en réalisent les organismes, est ensuite d’utiliser cette information spécifique, qui cesse alors d’être “potentielle” pour devenir “fonctionnelle”. C’est évidemment ce passage qui reste encore obscur (…). En effet, il se traduit essentiellement par le fait que les sources d’énergie fournies par l’environnement sont utilisées de façon à alimenter les échanges d’information à l’intérieur du système. Mais l’environnement ne peut fournir qu’une énergie sans valeur informationnelle ; ses effets ne peuvent être que des agressions aléatoires (car sinon il faudrait supposer une origine commune à l’information potentielle intérieure au système et à cette information éventuelle, venue de l’environnement !) On retrouve encore ainsi, par un nouveau chemin, la question du mécanisme par lequel des agressions aléatoires qui semblent a priori n’être que des facteurs d’erreurs, peuvent être utilisées par certaines structures, de façon à augmenter leur efficacité, et d’être en fait des facteurs d’organisation. Quels sont les caractères de ces structures qui les rendent ainsi capables d’utiliser les facteurs aléatoires de l’environnement ?

(…)

DEUXIÈME APPROCHE : LE PRINCIPE D’ORDRE À PARTIR DE BRUIT

(…)

Si on agite la boîte en permanence, en ne s’interrompant que pour l’ouvrir de temps en temps, on assiste à des transformations de l’ensemble des cubes, avec des formes successives qui suggéreraient à un observateur non averti l’existence d’une organisation. Pour un tel observateur, l’origine de cet ordre, ou de cette organisation ne peut se trouver que dans l’agitation — et il s’agit là de secousses désordonnées, donc de bruit — ainsi que, suivant l’expression de Von Foerster, dans l’existence de quelques petits démons dans la boîte. En fait, on peut se demander quelle est la cause d’une forme particulière : est-elle dans la secousse ? Dans l’aimantation des cubes ? Ou dans la forme précédente ? Il est évident qu’elle se trouve dans les trois facteurs à la fois, sans qu’aucun à lui seul ne suffise à produire telle ou telle forme particulière. C’est pourquoi celle-ci ne peut être trouvée nulle part à l’avance inscrite dans un programme, de quelque façon que ce soit. C’est à l’aide de cette analogie que Von Foerster a présenté son principe d’ordre à partir de bruit, “car aucun ordre n’a été injecté dans le système en dehors d’une énergie non orientée à bon marché ; cependant, à longue échéance, grâce aux petits démons de la boîte, seules les composantes du bruit qui pouvaient contribuer à augmenter l’ordre du système étaient sélectionnées. La survenue d’une mutation, par exemple, pourrait être comparée à ce mécanisme, en considérant les gamètes comme le système en question [26].

(…)

Il est évident que ce modèle a été choisi intentionnellement pour montrer que les démons organisateurs n’ont rien de fondamentalement différent des forces physiques connues, et ne doivent rien à quelque mystérieuse force vitale. En fait, il montre qu’il n’y a pas de véritable auto-organisation d’un point de vue physique, en ce sens que les états de structure successifs sont potentiellement contenus dans la magnétisation initiale des cubes et dans l’état d’énergie libre minimum qui en résulte. Sous l’effet de l’agitation le système prendra des formes différentes en même temps qu’il se rapprochera de plus en plus de son état d’équilibre, caractérisé par ce minimum d’énergie libre. En ce sens, il ressemble à la constitution de n’importe quelle structure moléculaire, où des atomes ou groupements moléculaires s’attachent à cause de l’affinité chimique qui existe entre eux, et produisent une diminution d’énergie libre du système ; ceci également sous l’effet de l’agitation thermique (aléatoire) grâce à laquelle les atomes et groupements moléculaires peuvent se rencontrer et interagir. Le fait que cette diminution d’énergie libre — donc cette atteinte de l’état d’équilibre — peut s’accompagner parfois d’une augmentation d’ordre avec diminution d’entropie, apparemment paradoxale, est illustré par les phénomènes de cristallisation. Le liquide qui se cristallise évolue lui aussi vers un état d’équilibre, caractérisé par une énergie libre minimum, mais dont l’entropie est plus faible, ainsi qu’en témoigne la structure du cristal. Un effet beaucoup plus intriguant du point de vue de la théorie thermodynamique serait obtenu dans un système imaginaire qui serait capable de sélectionner, parmi les différentes structures d’équilibre ainsi produites, certaines formes favorisées, tandis que d’autres seraient rejetées suivant des critères fonctionnels propres au système.

Source :

Henri Atlan, L’organisation biologique et la théorie de l’information, Seuil, 2006.

(…)

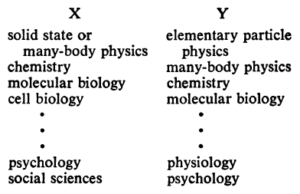

Avant de commencer, je souhaite éliminer deux sources possibles de malentendus. Tout d’abord, lorsque je parle de changement d’échelle entraînant un changement fondamental, je n’entends pas l’idée plutôt bien comprise selon laquelle les phénomènes à une nouvelle échelle peuvent obéir à des lois fondamentales réellement différentes – comme, par exemple, la relativité générale est requise à l’échelle cosmologique et la mécanique quantique à l’échelle atomique. Je pense que l’on admettra que toute la matière ordinaire obéit à l’électrodynamique simple et à la théorie quantique, ce qui couvre l’essentiel de ce dont je vais parler.

Mais cette hiérarchie n’implique pas que la science X soit “simplement Y appliquée”. À chaque étape, des lois, des concepts et des généralisations entièrement nouveaux sont nécessaires, exigeant inspiration et créativité à un degré tout aussi élevé qu’à l’étape précédente. La psychologie n’est pas de la biologie appliquée, pas plus que la biologie n’est de la chimie appliquée.

Mais cette hiérarchie n’implique pas que la science X soit “simplement Y appliquée”. À chaque étape, des lois, des concepts et des généralisations entièrement nouveaux sont nécessaires, exigeant inspiration et créativité à un degré tout aussi élevé qu’à l’étape précédente. La psychologie n’est pas de la biologie appliquée, pas plus que la biologie n’est de la chimie appliquée.(…)

Before beginning this I wish to sort out two possible sources of misunderstanding. First, when I speak of scale change causing fundamental change I do not mean the rather well-understood idea that phenomena at a new scale may obey actually different fundamental laws-as, for example, general relativity is required on the cosmological scale and quantum mechanics on the atomic. I think it will be accepted that all ordinary matter obeys simple electrodynamics and quantum theory, and that really covers most of what I shall discuss.

But this hierarchy does not imply that science X is “just applied Y.” At each stage entirely new laws, concepts, and generalizations are necessary, requiring inspiration and creativity to just as great a degree as in the previous one. Psychology is not applied biology, nor is biology applied chemistry.

But this hierarchy does not imply that science X is “just applied Y.” At each stage entirely new laws, concepts, and generalizations are necessary, requiring inspiration and creativity to just as great a degree as in the previous one. Psychology is not applied biology, nor is biology applied chemistry.Source :

Anderson, P.W. & Goldstein, Jeffrey. (2014). More is different: Broken symmetry and the nature of the hierarchical structure of science. 16. 117-134.

L’ambition de transition énergétique convoque des croyances animistes : le flux d’énergie rendu accessible par les ENS est supposé stable comme si les ENS étaient dotées de propriétés qui appartiennent au vivant.

Les sociétés thermo-industrielles, comme certains systèmes vivants hétérotrophes, ont accès à l’énergie grâce à des convertisseurs d’énergie : centrales thermiques, éoliennes, panneaux photovoltaïques ou centrales nucléaires pour les premières, organismes autotrophes pour les seconds. Les ENS, sur lesquelles s’appuie l’ambition de transition énergétique, diffèrent toutefois qualitativement des organismes autotrophes : elles ne disposent d’aucune capacité à entretenir par elles-mêmes leur capacité à capturer et convertir de l’énergie. Les ENS ne constituent pas des structures dissipatives, elles n’ont pas accès à l’auto-organisation.

Le taux de prélèvement d’énergie (TPE) pour l’entretien des ENS serait intrinsèquement croissant, et leur taux de retour énergétique (TRE) resterait indexé à l’évolution de la valeur du TPE. Plus le prélèvement serait grand dans le flux d’énergie, simplement afin d’entretenir ce même flux d’énergie, indépendamment de tout service rendu au système qui dépend de ce flux d’énergie, plus faible serait le TRE.

A contrario des infrastructures de conversion des sources d’énergie auxiliaire de l’humanité (hydrocarbures), l’organisation des ENS n’est pas entretenue par une interaction autocatalytique entre le système auto-organisé “humanité” et les sources d’énergie que l’humanité exploite. Afin que l’énergie du vent, l’énergie du rayonnement solaire ou celle des atomes puissent être considérées comme des sources d’énergie pour les sociétés humaines, même indirectes, il faudrait que les infrastructures de conversion de ces énergies puissent être elles-mêmes considérées comme des systèmes auto-organisés. Dans ce cas, les systèmes physiques constitués par les ENS seraient considérés ouverts sur l’énergie du vent, du rayonnement solaire et des atomes, puisque ces énergies constitueraient des flux d’entropie contribuant directement au maintien de leur organisation. Alors, les sociétés humaines, par l’intermédiaire des ENS, seraient également admises comme indirectement ouvertes sur l’énergie du vent, du rayonnement solaire ou des atomes, comme le sont les organismes hétérotrophes sur l’énergie provenant du Soleil. Cependant, les conditions d’accès à la capacité d’auto-organisation ne sont pas honorées par les ENS, elles ne constituent que des machines strictement passives.

Si certains systèmes physiques vivants sont des sources d’énergies pour d’autres, les machines ne peuvent constituer des sources d’énergie pour d’autres systèmes, même si leur fonction est de convertir de l’énergie. Elles sont en effet incapables de renouveler leur propre capacité à rendre l’énergie disponible.

Sources

Le “techno-animisme” décrit initialement les rapports singulier de la culture shintoïste à la technologie.

“Le techno-animisme ou technoanimisme est une culture de la pratique technologique où la technologie est imprégnée de caractéristiques humaines et spirituelles. Il suppose que la technologie, l’humanité et la religion peuvent être intégrées en une seule entité. En tant que théorie anthropologique, le techno-animisme examine les interactions entre les aspects matériels et spirituels de la technologie en relation avec les humains. Le techno-animisme a été étudié dans le contexte du Japon, puisque le techno-animisme trouve la plupart de ses racines dans la religion shintoïste, ainsi que dans la culture DIY [do it yourself] où la théorie de l’acteur-réseau et les agences non-humaines ont été étiquetées comme des pratiques techno-animistes.”

Source :

Heinz Von Foerster, “Sur les systèmes auto-organisateurs et leurs environnements”, adaptation d’une intervention devant le Symposium Interdisciplinaire sur les Systèmes Auto-Organisateurs, prononcée le 5 mai 1959, à Chicago, Illinois ; publié à l’origine dans Self-Organizing Systems, M.C. Yovits et S. Cameron (ed.), Pergamon Press, Londres, pp. 31-50 (1960).

Avant de répondre à la question, nous devons remarquer, si nous ne voulons pas être en perpétuel danger de confusion, qu’aucune machine ne peut être auto-organisée dans ce sens. Le raisonnement est simple. Définissons l’ensemble S des états de manière à préciser de quelle machine nous parlons. L'”organisation” doit alors, comme je l’ai dit plus haut, être identifiée avec f, la correspondance de S en S que le moteur de base de la machine (quelle que soit sa force) impose. La relation logique ici est que f détermine les changements de S:-f est défini comme l’ensemble des couples (si, sj) tels que la commande interne du système forcera l’état si à se transformer en sj. Permettre à f d’être une fonction de l’état, c’est rendre absurde tout le concept.

(…)

Si donc aucune machine ne peut être considérée comme auto-organisée, comment considérer, par exemple, l’Homéostat, qui réarrange son propre câblage, ou l’ordinateur qui écrit son propre programme ?

La nouvelle logique du mécanisme nous permet de traiter la question de manière rigoureuse. Nous commençons avec l’ensemble S des états, et supposons que f change, disons pour g. Nous avons donc bien une variable, disons α(t), une fonction du temps qui a d’abord eu la valeur f et plus tard la valeur g. Ce changement, comme nous venons de le voir, ne peut être attribué à aucune cause dans l’ensemble S; il doit donc provenir d’un agent extérieur, agissant sur le système S en tant qu’entrée. Si l’on veut que le système soit en quelque sorte auto-organisé, le “soi” doit être élargi pour inclure cette variable α, et, pour que l’ensemble reste limité, la cause du changement de α doit se trouver dans S (ou α).

Ainsi, l’apparence d’être “auto-organisé” ne peut être donnée que par la machine S étant couplée à une autre machine (d’une seule partie) :

(…)

Alors la partie S peut être “auto-organisatrice” au sein de l’ensemble S + α.

Ce n’est que dans ce sens partiel et strictement qualifié que nous pouvons comprendre qu’un système est “auto-organisé” sans être auto-contradictoire.

Étant donné qu’aucun système ne peut être correctement qualifié d’auto-organisé, et que l’utilisation de l’expression “auto-organisé” tend à perpétuer une manière fondamentalement confuse et incohérente d’aborder le sujet, il est probablement préférable de laisser cette expression disparaître.

Before the question is answered we must notice, if we are not to be in perpetual danger of confusion, that no machine can be self-organizing in this sense. The reasoning is simple. Define the set S of states so as to specify which machine we are talking about. The “organization” must then, as I said above, be identified with f, the mapping of S into S that the basic drive of the machine (whatever force it may be) imposes. Now the logical relation here is that f determines the changes of S:-f is defined as the set of couples (si, sj) such that the internal drive of the system will force state si to change to sj. To allow f to be a function of the state is to make nonsense of the whole concept.

(…)

If, then, no machine can properly be said to be self-organizing, how do we regard, say, the Homeostat, that rearranges its own wiring; or the computer that writes out its own program?

The new logic of mechanism enables us to treat the question rigorously. We start with the set S of states, and assume that f changes, to g say. So we really have a variable, α(tv) say, a function of the time that had at first the value f and later the value g. This change, as we have just seen, cannot be ascribed to any cause in the set S; so it must have come from some outside agent, acting on the system S as input. If the system is to be in some sense “self-organizing,” the “self” must be enlarged to include this variable α, and, to keep the whole bounded, the cause of α’s change must be in S (or α).

Thus the appearance of being “self-organizing” can be given only by the machine S being coupled to another machine (of one part):

(…)

Then the part S can be “self-organizing” within the whole S + α.

Only in this partial and strictly qualified sense can we understand that a system is “self-organizing” without being self-contradictory.

Since no system can correctly be said to be self-organizing, and since the use of the phrase “self-organizing” tends to perpetuate a fundamentally confused and inconsistent way of looking at the subject, the phrase is probably better allowed to die out.

Source :

W. R. Ashby (1962), “Principles of the self organizing system”, In Principles of Self Organization, Eds H. Von Foerster and G. N. Zopf, Pergamon, p. 255-278. Dans : Atlan Henri. Du bruit comme principe d’auto-organisation. In: Communications, 18, 1972. L’événement. pp. 21-36; doi : https://doi.org/10.3406/comm.1972.1256

Article “Autopoiesis and Cognition: The Realization of the Living”

L’usage que l’homme peut faire d’une machine n’est pas une caractéristique de l’organisation de la machine, mais du domaine dans lequel la machine fonctionne, et appartient à notre description de la machine dans un contexte plus large que la machine elle-même. C’est une notion importante. Les machines fabriquées par l’homme sont toutes fabriquées dans un but quelconque, pratique ou non, mais avec un objectif (même si ce n’est que pour s’amuser) que l’homme spécifie. Ce but apparaît généralement exprimé dans le produit du fonctionnement de la machine, mais pas nécessairement. Cependant, nous utilisons la notion de but en parlant des machines parce qu’elle fait appel à l’imagination de l’auditeur et réduit la tâche explicative dans l’effort de lui transmettre l’organisation d’une machine particulière. En d’autres termes, avec la notion de finalité, nous incitons l’auditeur à inventer la machine dont nous parlons. Cela ne doit cependant pas nous amener à croire que le but, l’objectif ou la fonction sont des propriétés constitutives de la machine que nous décrivons avec elles ; ces notions sont intrinsèques au domaine d’observation et ne peuvent pas être utilisées pour caractériser un type particulier d’organisation de la machine. Le produit des opérations d’une machine, cependant, peut être utilisé à cette fin d’une manière non triviale dans le domaine des descriptions générées par l’observateur.