Méthodologie de la transition

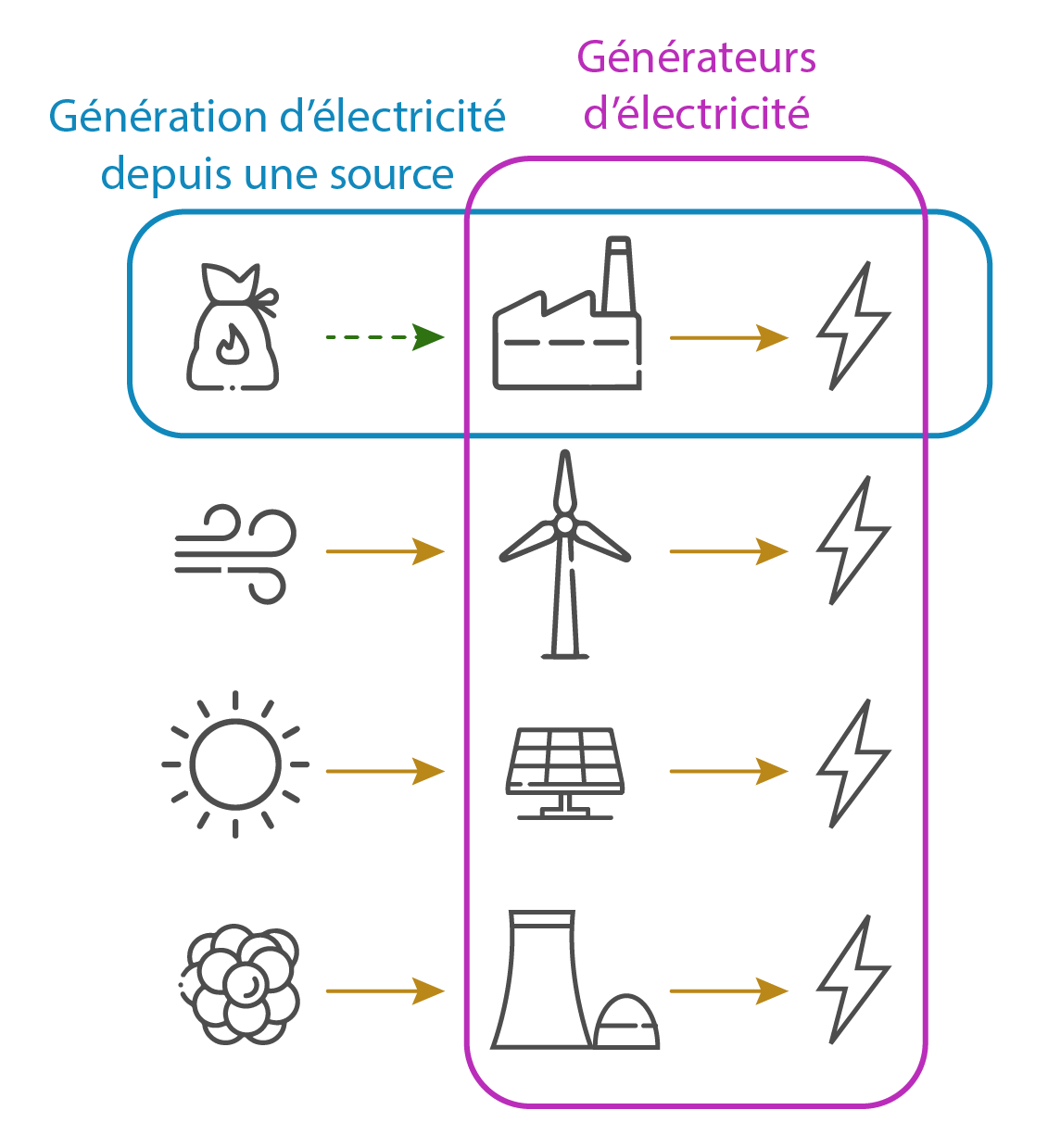

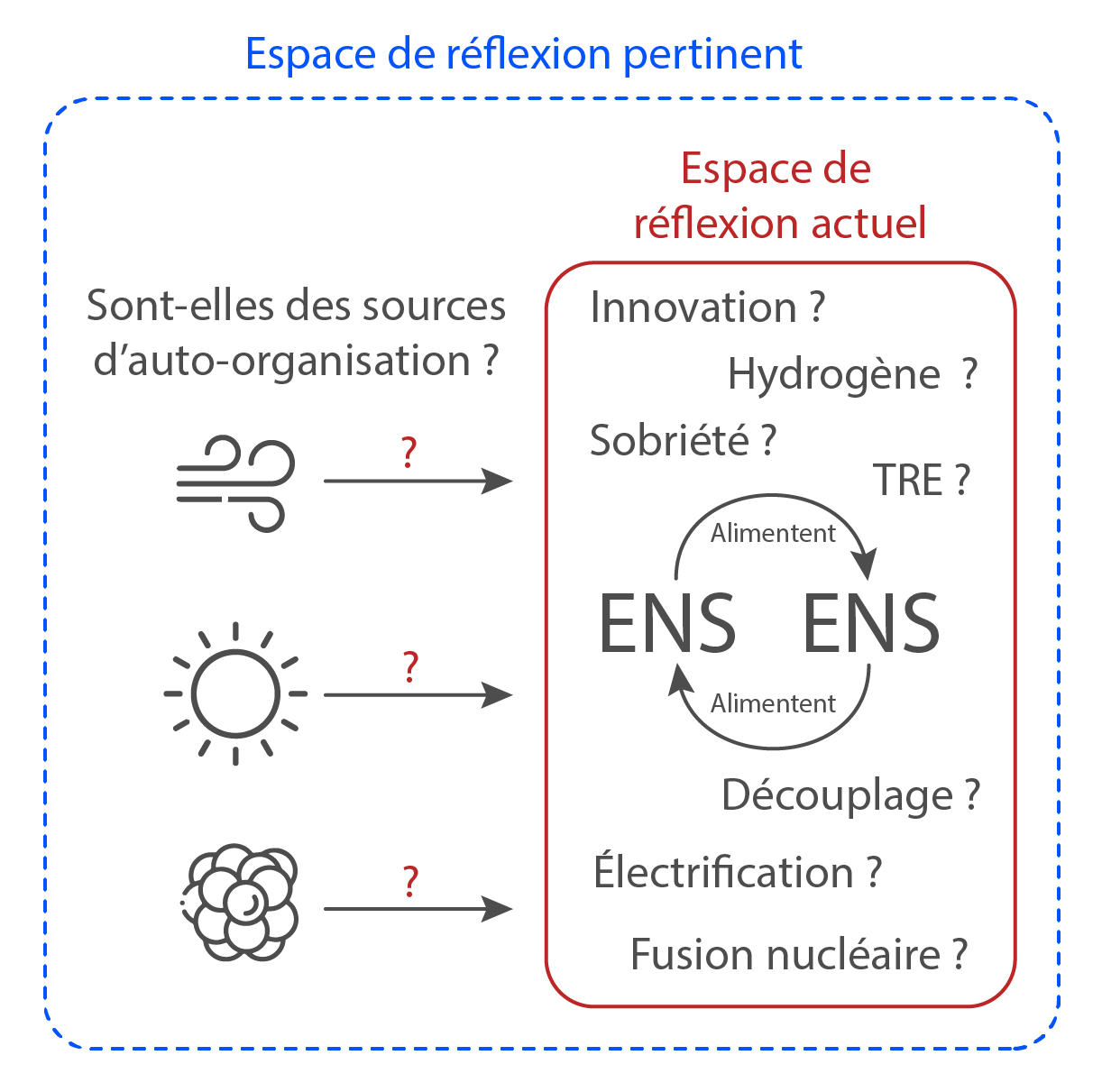

Selon les connaissances théoriques et expérimentales rappelées sur le site Défi énergie, la substitution des énergies ne serait pas envisageable. La méthodologie de la transition n’aurait pas tenu compte de certaines propriétés des sociétés thermo-industrielles, qui leur interdiraient de s’organiser à partir de toute les formes d’énergie présentes dans leur milieu. La conviction que toutes les énergies seraient substituables pour les besoins des sociétés humaines trouve peut-être sa source dans la confusion, involontaire, entre certains critères qualitatifs, qui définissent les propriétés du réel, et des paramètres quantitatifs, qui constituent des abstractions potentiellement indépendantes de ces propriétés. Une approche quantitative aurait en particulier autorisé des catégorisations arbitraires, procurant aux énergies dites de substitution (ENS : éoliennes, panneaux photovoltaïques, centrales nucléaires) des propriétés qu’elles ne possèdent pas en réalité.

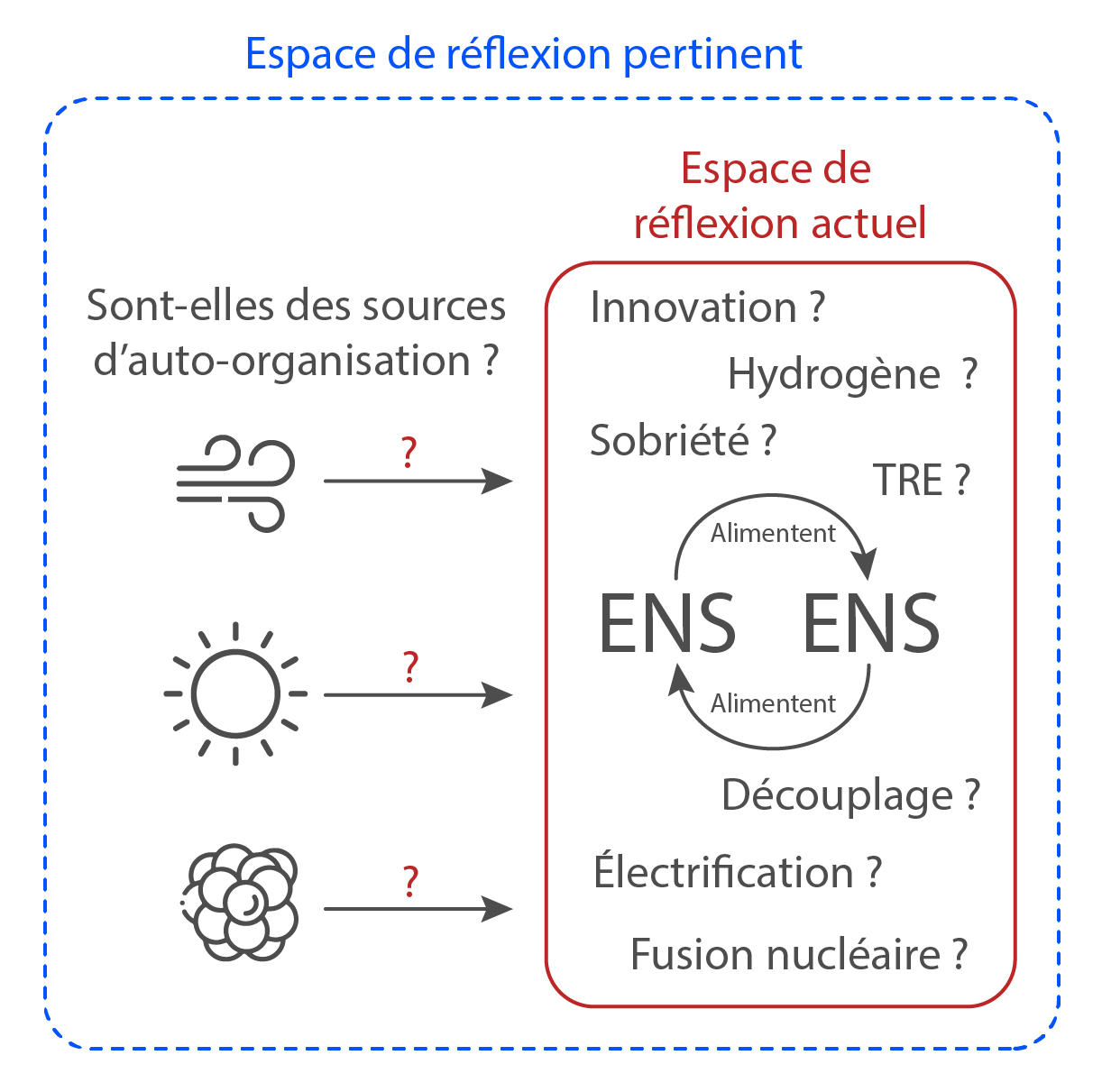

Envisager que les sociétés thermo-industrielles puissent passer de l’exploitation de sources d’énergie à celle d’énergies auxiliaires implique la résolution de problématiques qualitatives : il est nécessaire de démontrer que les formes d’énergie contenues dans le vent, le rayonnement solaire ou les atomes sont à même de pourvoir à l’organisation des sociétés thermo-industrielles.

Cette démonstration engage à la compréhension des liens logiques et causaux qu’entretiennent les sociétés thermo-industrielles avec les différentes formes d’énergie présentes dans leur milieu.

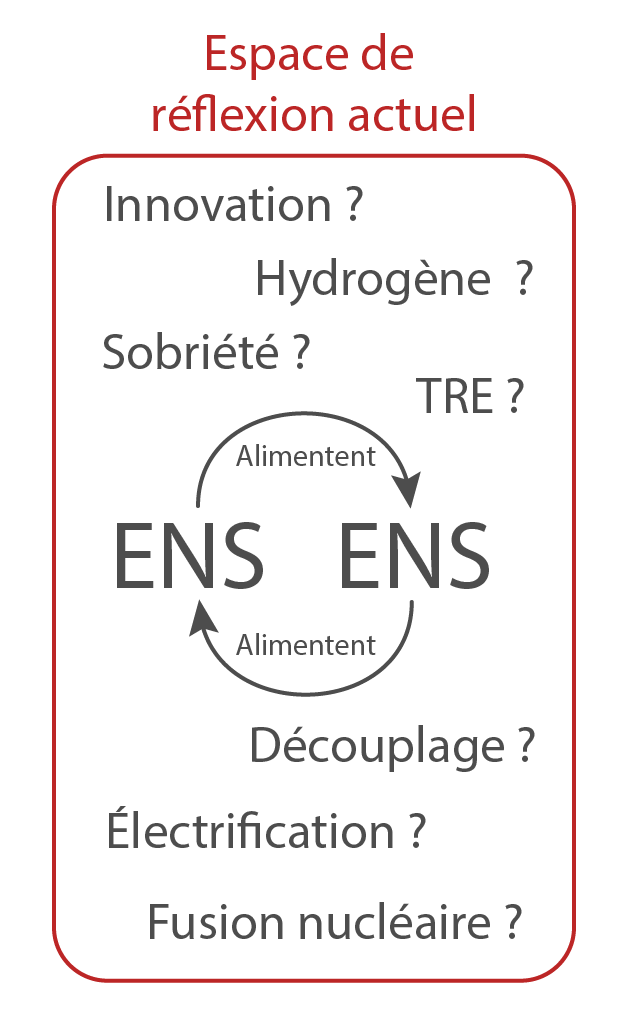

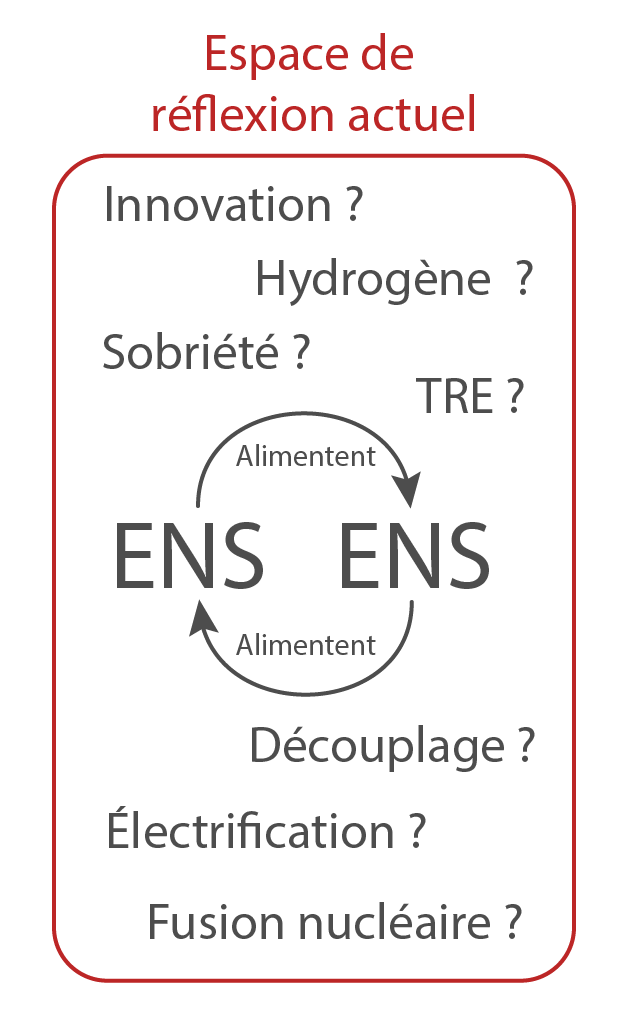

La littérature scientifique sur la transition a, semble-t-il, estimé jusque-là que la substituabilité des énergies reposait sur la construction d’une quantité suffisante d’ENS, ou sur l’amélioration de leurs performances : éoliennes plus grandes, panneaux photovoltaïques aux rendements plus élevés, accès à une quantité plus importante ou plus concentrée d’énergie grâce à la fission ou à la fusion nucléaire. Dans l’ensemble, la recherche sur la transition a porté sur l’obtention du meilleur taux de retour énergétique possible (TRE : rapport entre la quantité d’énergie investie pour obtenir de l’énergie et la quantité d’énergie obtenue en retour, précisions en suivant ce lien).

Mais les performances de machines qui convertissent de l’énergie ne disent rien de leur capacité à procurer un flux d’énergie organisateur aux sociétés avec lesquelles elles sont en interaction, et qui attendent d’elles d’entretenir leur propre complexité. Une quantité d’énergie et un flux organisateur (ou flux d’entropie) sont deux choses différentes.

Sources

L’adjectif qualitatif signifie « qui concerne la qualité, la nature d’une chose et de ses éléments constitutifs » et s’oppose à quantitatif. Une étude qualitative est donc une étude portant sur la qualité d’un produit, d’un service, etc., et non une étude de haut niveau. On se gardera bien de confondre l’adjectif qualitatif avec la locution adjectivale de qualité ou des formes de même sens.

Ainsi en arrive-t-on progressivement à une vision du monde dans laquelle la matérialité des choses semble se dissoudre en équations. Une vision dans laquelle le matérialisme est de plus en plus contraint d’évoluer vers le mathématisme et où, si l’on peut dire, Démocrite doit en définitive se réfugier chez Pythagore. Qu’est-ce, en effet, que la matière ? Ce qui se conserve, disait-on autrefois. Ce n’est donc pas la masse. À moins d’identifier celle-ci à l’énergie (à l’unité de mesure près). Mais cette dernière entité, l’énergie, n’est elle-même rien d’autre que la pure « immatérialité » d’une composante de quadrivecteur dans un espace-temps qui – pour faire bonne mesure – est « courbe » ! Ou bien identifierai-je la matière d’un objet à l’ensemble de ses « atomes de Démocrite » ? La conservation de la matière sera-t-elle alors celle de ces « atomes », c’est-à-dire celle des particules qui la constituent ? Les choses ne peuvent être aussi simples puisque des particules peuvent s’annihiler – avec leurs « antiparticules » – au seul profit d’une accélération de particules préexistantes. Les particules elles-mêmes ne se conservent donc pas toujours. Il est vrai que certains nombres, certaines différences entre nombres de particules et nombres d’antiparticules, sont conservés. Mais, de nouveau, ce sont là quantités abstraites. Initialement conçu pour représenter une propriété d’un ensemble, autrement dit une entité distincte de celui-ci (une collection de billes est autre chose, pensait-on, que le nombre de billes de la collection), voilà que le nombre apparaît maintenant en physique comme l’entité ayant seule une stabilité suffisante pour que cette science le prenne vraiment au sérieux.

De là à affirmer, avec les pythagoriciens, que les nombres sont l’essence des choses, il n’y a qu’un pas. Et il faut même noter qu’il ne peut ici être question d’un simple pythagorisme édulcoré. Il faut un pythagorisme essentiel, je veux dire inconciliable en définitive avec la vision démocritéenne qui pose l’éternité des grains ultimes. En d’autres termes il n’est plus possible d’emprunter à Démocrite sa conception fondamentale du réel en ajoutant seulement que les « atomes » interagissent par des forces obéissant à certaines formules ; et que le critère de la beauté mathématique s’avère fécond en ce qui concerne la recherche de ces dernières. Une telle tentative de conciliation entre Démocrite et Pythagore ne résoudrait rien puisque, encore une fois, aucun « grain » situé dans l’espace n’apparaît comme indestructible. Puisque, bien au contraire, tous peuvent subir l’annihilation, et que les seules entités assez stables pour que la physique puisse envisager de les regarder comme fondamentales sont des nombres, des fonctions ou d’autres êtres mathématiques d’apparence encore plus abstraite. « Tout est géométrie » proclament volontiers certains spécialistes de la théorie de la relativité générale.

Source :

Bernard D’Espagnat, À La recherche du réel. Le regard d’un physicien, Dunod, 1988.

On peut distinguer deux types d’énoncés synthétiques universels : les “strictement universels” et les “numériquement universels”. Ce sont les énoncés strictement universels que j’ai eus à l’esprit jusqu’à présent en parlant d’énoncés universels de théories ou de lois naturelles. L’autre type d’énoncés, les énoncés numériquement universels, sont en fait équivalents à certains énoncés singuliers, ou à des conjonctions d’énoncés singuliers, et ils seront classés ici dans la catégorie des énoncés singuliers.

Comparons, par exemple, les deux énoncés suivants : (a) Il est vrai que l’énergie de tous les oscillateurs harmoniques ne tombe jamais en dessous d’une certaine valeur (viz. hv/2) ; et (b) Il est vrai que la taille de tous les êtres humains vivant actuellement sur la terre ne dépasse jamais une certaine valeur (disons 8 pieds). La logique formelle (y compris la logique symbolique), qui ne s’intéresse qu’à la théorie de la déduction, traite ces deux énoncés comme des énoncés universels (implications “formelles” ou “générales”). Je pense cependant qu’il est nécessaire de souligner la différence entre ces deux énoncés. L’énoncé (a) prétend être vrai en tout lieu et en tout temps. L’affirmation (b) ne se réfère qu’à une classe finie d’éléments spécifiques au sein d’un espace fini région spatio-temporelle individuelle (ou particulière). Les énoncés de ce dernier type peuvent, en principe, être remplacés par une conjonction d’énoncés singuliers ; car avec un temps suffisant, on peut énumérer tous les éléments de la classe (finie) concernée. C’est pourquoi on parle dans ce cas d'”universalité numérique”. En revanche, l’énoncé (a), concernant les oscillateurs, ne peut pas être remplacé par une conjonction d’un nombre fini d’énoncés singuliers concernant une région spatio-temporelle definie ; ou plutôt, il ne pourrait être remplacé que si l’on supposait que le monde est limité dans le temps et qu’il n’existe qu’un nombre fini d’oscillateurs en son sein. Mais nous ne faisons pas une telle hypothèse ; en particulier, nous ne faisons pas une telle hypothèse en définissant les concepts de la physique. Nous considérons plutôt un énoncé de type (a) comme un énoncé global, c’est-à-dire une affirmation universelle concernant un nombre illimité d’individus. Ainsi interprété, il ne peut clairement pas être remplacé par une conjonction d’un nombre fini d’énoncés singuliers.

We can distinguish two kinds of universal synthetic statement: the ‘strictly universal’ and the ‘numerically universal’. It is the strictly universal statements which I have had in mind so far when speaking of universal statements—of theories or natural laws. The other kind, the numerically universal statements, are in fact equivalent to certain singular statements, or to conjunctions of singular statements, and they will be classed as singular statements here.

Compare, for example, the following two statements: (a) Of all harmonic oscillators it is true that their energy never falls below a certain amount (viz. hv/2); and (b) Of all human beings now living on the earth it is true that their height never exceeds a certain amount (say 8 ft.). Formal logic (including symbolic logic), which is concerned only with the theory of deduction, treats these two statements alike as universal statements (‘formal’ or ‘general’ implications). I think however that it is necessary to emphasize the difference between them. Statement (a) claims to be true for any place and any time. Statement (b) refers only to a finite class of specific elements within a finite individual (or particular) spatio-temporal region. Statements of this latter kind can, in principle, be replaced by a conjunction of singular statements; for given sufficient time, one can enumerate all the elements of the (finite) class concerned. This is why we speak in such cases of ‘numerical universality’. By contrast, statement (a), about the oscillators, cannot be replaced by a conjunction of a finite number of singu- lar statements about a definite spatio-temporal region; or rather, it could be so replaced only on the assumption that the world is bounded in time and that there exists only a finite number of oscillators in it. But we do not make any such assumption; in particular, we do not make any such assumption in defining the concepts of physics. Rather we regard a statement of type (a) as an all-statement, i.e. a universal assertion about an unlimited number of individuals. So interpreted it clearly cannot be replaced by a conjunction of a finite number of singular statements.

Source :

Popper, Karl. (2005). The Logic of Scientific Discovery. 10.4324/9780203994627.

Source :

Alain Supiot, La Gouvernance par les nombres, Paris, Fayard, 2015.

Source :

Murphy DJ, Carbajales-Dale M, Moeller D. Comparing Apples to Apples: Why the Net Energy Analysis Community Needs to Adopt the Life-Cycle Analysis Framework. Energies. 2016; 9(11):917. https://doi.org/10.3390/en9110917

L’idée que l’on puisse remplacer la construction des connaissances scientifiques par une quantité suffisante de données s’est de plus en plus imposée ces dernières années. « La corrélation remplace la causalité […]. Là où on dispose d’assez de données, les chiffres parlent par eux-mêmes […]. Aucune analyse sémantique ou causale n’est demandée. »

(…)

D’une part, si on torture suffisamment les données, elles finiront bien par confesser – les statisticiens le savent très bien. D’autre part, si nous avons suffisamment de données nous pouvons y trouver n’importe quelle corrélation. Essayons de préciser ces remarques. La « torture » la plus fréquente consiste dans le forçage d’un biais dans le choix des observables ou de la mesure : un regard et une mesure biaisés permettent de lire à leur aune n’importe quel phénomène. On choisit de mesurer (comment ?) certains observables et pas d’autres – la couleur de la peau par exemple, dans la « justice prédictive ». Et pourtant, ce n’est pas sur la base de corrélations sans interprétation que les choses marchent réellement dans les sciences, où l’analyse de la causalité est très importante, en biologie et médecine notamment.

Quant aux corrélations, les mathématiques nous disent que, justement, quand on a « beaucoup » de nombres, on en trouve toujours. Ainsi, nous rappelions que des résultats classiques en théorie combinatoire des nombres permettent de démontrer que, quelle que soit la corrélation entre des nombres que l’on se donne, il est possible de calculer un nombre m tel que toute base de données ayant au moins m éléments contienne la corrélation donnée.

Ce n’est donc qu’une question de taille, car ces résultats démontrent que toute « base de données » – c’est-à-dire en réalité tout ensemble de nombres – suffisamment grande, quand bien même elle serait produite par le hasard, par exemple par des lancements de dés, des mesures quantiques, contient des régularités présentant les caractéristiques demandées : autrement dit, si on dispose d’une quantité considérable de nombres, on peut trouver « n’importe quoi ». Plus précisément : nous pouvons toujours trouver ce que nous cherchions au départ.

Source :

Giuseppe Longo, Le Cauchemar de Prométhée. Les sciences et leurs limites, PUF, Paris, 2023.

Maxwell précise par ailleurs, non sans malice, sa motivation à investir les méthodes quantitatives en physique : “Je m’abstiens soigneusement de demander aux molécules qui entrent d’où elles sont parties la dernière fois. Je me contente de les compter et d’enregistrer leurs vitesses moyennes, en évitant toute enquête personnelle qui ne ferait que m’attirer des ennuis.”

Les sciences sociales, dès leur développement, se seraient confrontées à une telle difficulté d’appréhension des phénomènes qu’elles auraient préféré les aborder par circonscription artificielle et approximation quantitative. La physique, rencontrant elle aussi la complexité, aurait investi une méthode comparable. Aussi indispensables qu’elles aient été pour l’étude des propriétés fines du monde, les méthodes statistiques ont pu engendrer des biais interprétatifs, dont il semble important de tenir compte afin d’éclairer le débat sur l’irréversibilité et l’imprédictibilité. L’étude quantitative des interactions entre les particules ne se substitue sans doute pas sans vigilance à leur étude qualitative.

Source :

Mignerot, V. (2022). La transition énergétique résiliente. Cités, 92, 57-68. https://www.cairn.info/revue-cites-2022-4-page-57.htm

Comprendre les liens logiques et causaux qui régissent les interactions entre les entités du réel implique de les catégoriser en fonction des caractéristiques qui les définissent. Ces caractéristiques peuvent être appréhendées plutôt en “locus interne” (en observant les propriétés internes des entités, et l’effet de ces propriétés sur d’autres entités), ou plutôt en “locus externe” (en observant les relations qu’établissent ces entités avec d’autres, et l’effet de ces relations sur leurs propriétés).

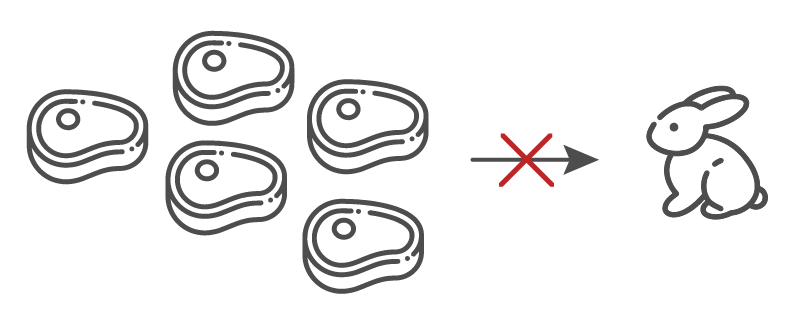

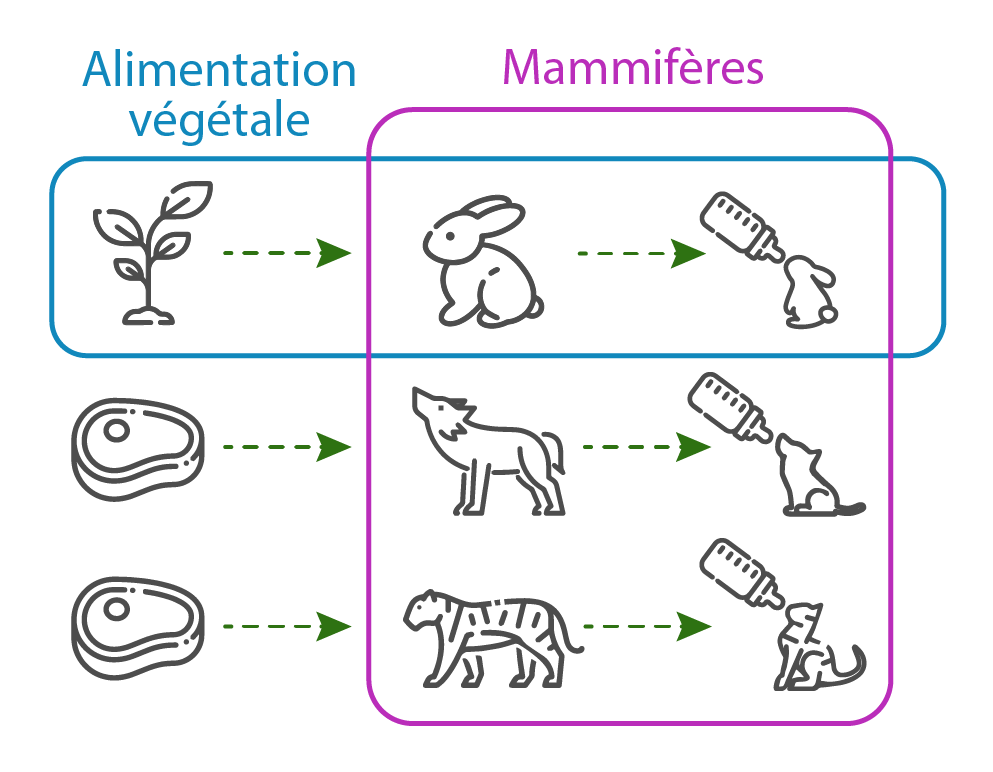

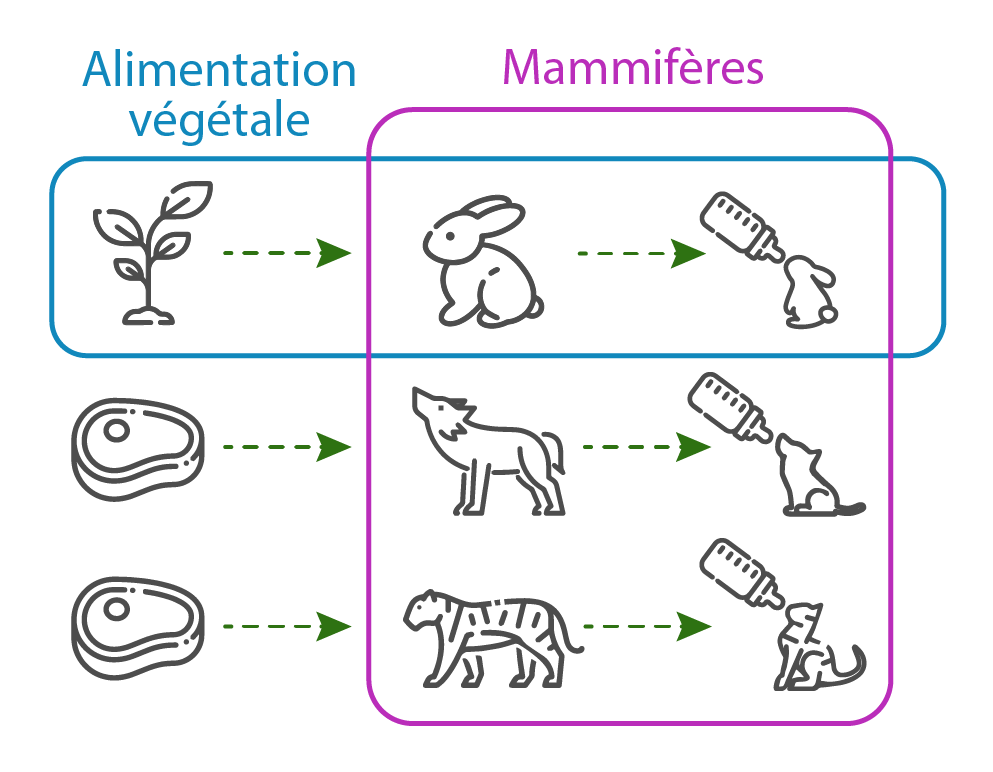

Par exemple, si l’on se demande à quelle catégorie appartiennent les animaux “lapins”, au-delà de la catégorie des “animaux” il est possible de les classer parmi les “mammifères”, ou parmi les “herbivores”. Une des deux catégorisations est établie à partir de caractéristiques internes aux lapins (locus interne) : les lapins sont des “vertébrés dont les femelles allaitent leurs petits”. La seconde catégorisation est établie à partir des caractéristiques externes aux lapins (locus externe) : pour se nourrir, les lapins doivent entretenir des interactions avec d’autres choses qu’eux-mêmes, des végétaux.

Les catégorisations en locus interne, définies à partir d’un nombre restreint de caractères intrinsèques, peuvent induire des erreurs de raisonnement, dès qu’il s’agit de comprendre la place ou le rôle de ce qu’on étudie au cœur d’un système. Pour comprendre les besoins vitaux des lapins, et en prendre soin correctement, il est plus sûr de savoir de quoi ils se nourrissent, plutôt que de les réduire à la catégorie “mammifère”, qui comprend des animaux aux alimentations très différentes.

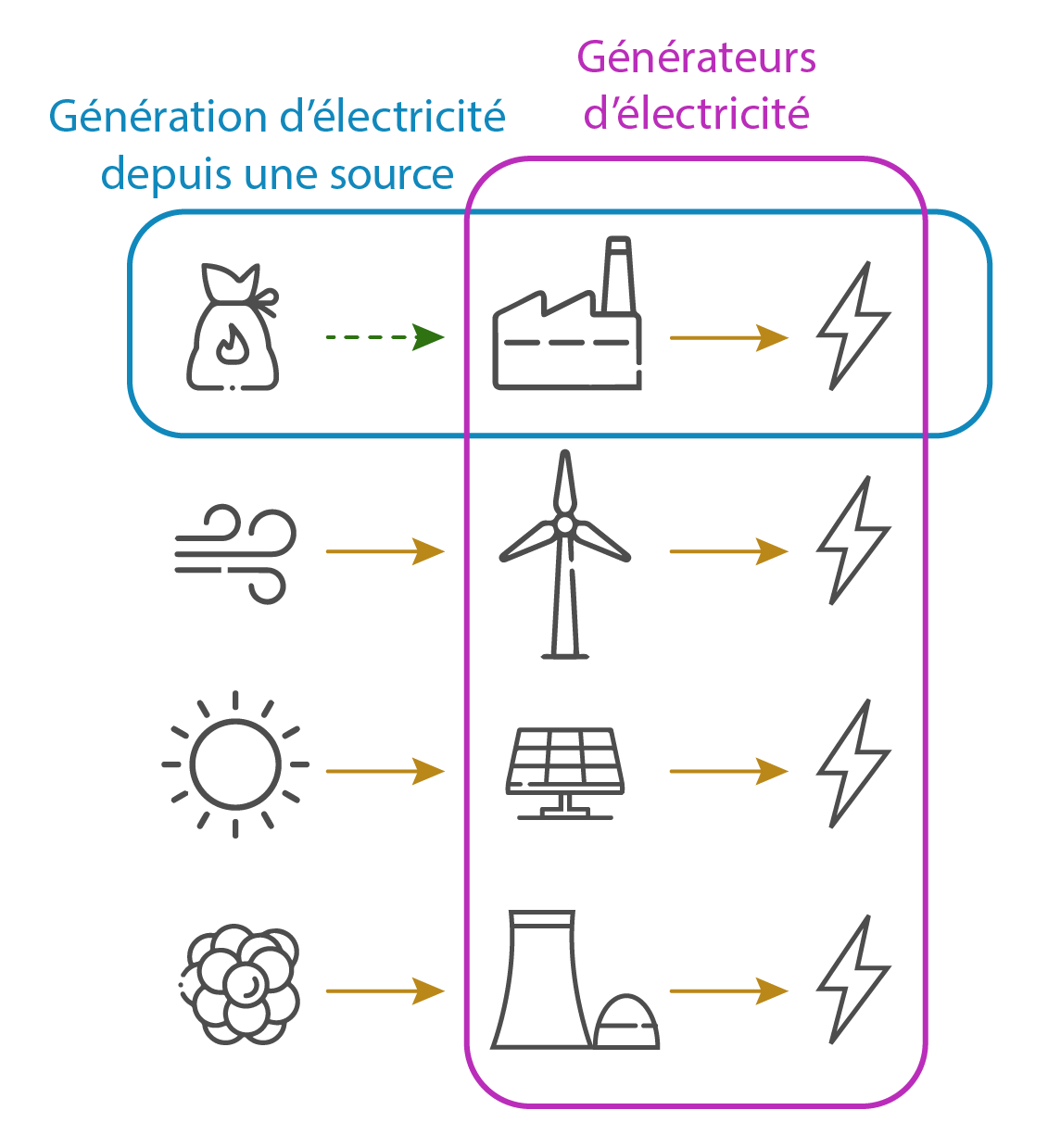

De la même façon, afin de déterminer si une substitution des énergies est envisageable grâce à des ENS, se contenter de leur appartenance à la catégorie “convertisseurs d’énergie” est insuffisant. Afin de garantir qu’une décarbonation est possible, il est nécessaire de considérer les interactions qui doivent être entretenues entre les ENS et autre chose qu’elles-mêmes afin qu’elles puissent être déployées, entretenues et remplacées.

Sources

“[Il faut] rendre parfait ce qui dépend de nous, et prendre les autres choses comme elles viennent.” Épictète

On peut dire schématiquement qu’il existe deux types de personnes : celles qui pensent qu’elles ne doivent qu’à elles-mêmes ce qui leur arrive, et celles qui pensent à l’instar de Jacques le Fataliste que “tout est écrit là-haut” (“là-haut” pouvant être assimilé à toute forme de transcendance). C’est le point de départ du psychologue américain Julian Rotter pour élaborer sa théorie de l’apprentissage social de la personnalité.

Julian Rotter nomme locus de contrôle ces deux modes d’appréhension de la vie : ceux qui croient que les événements ne dépendent que d’eux ont un locus de contrôle interne (LCI) et ceux qui pensent que ces événements sont le fait de facteurs extérieurs ont un locus de contrôle externe (LCE). Si au travail vous obtenez une promotion et que vous avez un LCI, vous vous direz que c’est grâce à vos efforts. Si en revanche vous avez un LCE, vous attribuerez plutôt cette promotion à la chance ou à l’absence de concurrence. Précisons dès à présent que le locus de contrôle n’est pas une variable binaire, nous n’avons jamais un locus 100 % interne ou 100 % externe, mais nous penchons plutôt vers l’un ou vers l’autre et cela peut évoluer au cours de notre vie et en fonction de nos expériences.

En 1955, Jerry Phares, l’un des étudiants de Rotter, met en place un protocole expérimental pour montrer que notre locus de contrôle a un impact important sur nos performances et l’estime de soi. Il confie à deux groupes de personnes la réalisation d’une même tâche, très facile, qui consiste à déterminer parmi plusieurs angles lesquels sont égaux. Il dit au premier groupe que l’exercice est très difficile et dépend en grande partie du hasard (LCE), et au deuxième groupe que c’est une affaire de compétences (LCI). Phares demande ensuite aux participants des deux groupes d’évaluer le pourcentage de chances qu’ils ont de réussir ou d’échouer. Les résultats obtenus montrent que leur manière de s’auto évaluer a priori est conditionnée par ce qu’ils croient être ou non de leur ressort. Ceux qui pensent que c’est une question de hasard sont moins sûrs de réussir l’exercice que ceux qui pensent que leur réussite ne dépend que de leurs compétences propres.

Au quotidien, nous n’avons pas toujours quelqu’un derrière nous comme Phares pour nous dire que telle chose dépend de nous et telle autre du hasard. C’est à nous d’évaluer la part de contrôle que nous avons sur nos actions. Et lorsque nous l’évaluons mal, cela peut avoir des conséquences importantes. Par exemple, l’idée que les femmes sont moins fortes en mathématiques que les hommes est largement répandue, alors qu’on n’a jamais observé de différence biologique entre les sexes qui justifierait une différence de niveau en mathématiques. C’est ce que l’on appelle un biais de stéréotypage négatif : nous attribuons de façon inconsciente des caractéristiques négatives à un groupe de population sans aucun bien-fondé.

Steven J. Spencer, professeur de psychologie à l’université de l’Ohio, a voulu voir s’il était possible d’éliminer ce biais grâce à l’expérience suivante : dans un premier temps, il a réuni un groupe d’hommes et de femmes de niveau similaire en mathématiques, et les a soumis à un examen standard. Le résultat de ce test indique que les hommes réussissent mieux l’examen que les femmes. Dans un deuxième temps, il a reproduit à un détail près la même expérience avec deux nouveaux groupes mixtes, en précisant au premier groupe que ce test a déjà été réalisé et que les hommes l’ont mieux réussi que les femmes. En revanche, il dit au deuxième groupe que les résultats des précédents tests indiquent qu’hommes et femmes ont réalisé des performances similaires. Rappelons que les deux groupes ont effectué le même test.

En toute logique, si les performances étaient dues à des différences de niveau innées entre les hommes et les femmes, les résultats de la deuxième étude devraient être similaires aux résultats de la première. Or, si les résultats du premier groupe montrent bien une grande différence de niveau entre les hommes et les femmes, les résultats du deuxième groupe indiquent que les hommes et les femmes ont un taux de réussite quasi-identique. Il a suffi d’une phrase pour éliminer la différence de performance. Les résultats du deuxième groupe montrent qu’il est donc possible de “recalibrer” le locus de contrôle des femmes sur un axe plus interne en annulant le biais de stéréotype sociétal (que les femmes ne subissent pas seulement pour les mathématiques).

Locus de contrôle et sentiment de responsabilité

Notre locus de contrôle conditionne nos actions et par conséquent les résultats de nos actions. Nous ne nous sentons pas responsables de celles-ci de la même manière selon que nous penchons vers un LCI ou un LCE. De nombreux articles de recherche ont en effet démontré qu’un LCI conduit le sujet à davantage de responsabilisation et contribue à une plus grande estime de soi qu’un LCE. Si vous penchez vers un LCI, vous attribuerez vos réussites à vos compétences propres et donc développerez une bonne estime de vous-même. Plus vous penchez vers un LCE, plus vous allez attribuer vos victoires à des facteurs externes et donc en tirer moins de satisfaction personnelle. Dans le cas d’un échec, si vous penchez vers un LCI vous vous direz que vous ferez tout pour réussir la prochaine fois, alors que si vous penchez vers un LCE vous serez plus fataliste et vous aurez tendance à attribuer votre échec à des facteurs que vous ne pouvez pas et ne pourrez jamais contrôler.

Toutefois, si vous penchez trop vers un LCI cela peut aussi avoir des conséquences négatives. Dans le cadre d’événements qui ne dépendent pas de vous (ou en tout cas pas uniquement de vous), comme un licenciement économique, vous intérioriserez l’échec et réagirez comme si ce qui vous arrivait était de votre faute, ce qui peut vous conduire à développer des symptômes anxieux voire dépressifs. En revanche, dans ce genre de situation, quelqu’un qui penche plutôt vers un LCE relativisera davantage et surmontera plus facilement le choc causé par le licenciement.

Intéressons-nous à présent à l’impact de notre locus de contrôle sur notre santé. Si une personne atteinte du cancer se sent responsable de sa maladie ou si, à l’inverse, elle croit que sa maladie est uniquement une question de malchance, elle ne réagira pas de la même façon au diagnostic et au traitement. Notre manière d’envisager notre santé façonne la manière dont on affronte la maladie. Un patient qui penche vers un LCI mettra probablement plus d’énergie dans sa guérison, sera plus consciencieux dans la prise de ses médicaments qu’un malade qui croit que, quoi qu’il fasse, tout est écrit là-haut. Celui-ci adoptera une attitude plus passive et fataliste face à la maladie, une attitude d’impuissance acquise, qui pourrait se résumer ainsi : si rien ne dépend de moi, à quoi bon lutter et essayer de m’en sortir ?

Source :

Albert Moukheiber, Votre cerveau vous joue des tours, Allary Editions, 2019.

(…)

Elle propose donc une explication alternative des biais observés dans les sociétés libérales et individualistes (Choi, Nisbett, & Norenzayan, 1999 ; Ji, Peng, & Nisbett, 2000 ; Miller, 1984 ; Norenzayan & Nisbett, 2000). Qu’ils apparaissent dans le cadre de l’explication des comportements (soi ou autrui) ou des renforcements, que les chercheurs les appellent “erreur fondamentale d’attribution” (Ross, 1977), “biais de correspondance” (Gilbert & Malone, 1995), “illusion de contrôle” (Langer, 1975) ou “illusion de justice” (Lerner & Miller, 1978), ces biais traduisent tous un même phénomène : une accentuation du poids causal de l’acteur dans l’explication des événements. Cette accentuation du déterminisme individuel serait, pour les tenants de la conception normative de l’internalité, la traduction d’une attente sociale qui se manifesterait dans les situations évaluatives et qui conduirait les personnes des sociétés libérales et individualistes à préférer les gens qui expriment des croyances internes pour des raisons indépendantes de leur efficacité effective (cf. Beauvois, Bourjade & Pansu, 1991).

Depuis les travaux princeps de Jellison et Green (1981), de nombreuses recherches conduites auprès de populations variées (e.g. étudiants, salariés, chômeurs, élèves, enseignants) ont donné à la théorie de la norme d’internalité une assise empirique forte (voir Dubois, 2006, 2009 ; Dubois & Beauvois, 2008 ; Pansu, 2006 ; Pansu, Bressoux, & Louche, 2003 ; Pansu et al., 2008).

(…)

La prise en considération de l’approche normative de l’internalité (Beauvois, 1984, 2005) pose l’origine de la production explicative à un autre niveau. Cette production relèverait certes d’un traitement cognitif “mais d’un traitement cognitif subissant une imprégnation idéologique et aboutissant à la naturalisation des valeurs de l’environnement social” (Pansu & Sarrazin, 2010).

(…)

Les explications ou jugements que nous émettons s’inscrivent donc dans des pratiques sociales instituées comme telles. Ce qui s’observe ensuite à un niveau individuel relèverait en grande partie de la naturalisation de cette pensée. En proposant une explication basée sur la nature des rapports sociaux à l’oeuvre dans les situations d’évaluation (donc liée à l’exercice du pouvoir et aux idéologies psychologisantes d’une société), la théorie de la norme d’internalité se situe à un niveau d’explication sociétal (Doise, 1982, 2004). En d’autres termes, l’activité explicative ne se construirait pas dans un vide social mais serait sous l’influence d’exigences normatives qui inciteraient les individus à préférer certaines explications (les explications internes) plutôt que d’autres (les explications externes). Aussi, la préférence pour l’internalité observée dans les études traitant du LOC [Locus of control] est envisagée ici, non seulement comme le fait de certaines personnalités qui se caractériseraient par des comportements particuliers qu’on suppose plus adaptatifs, mais encore et peut-être surtout comme un type de jugements sociaux nécessaires pour permettre l’évaluation des individus dans les sociétés occidentales, individualistes et libérales.

Source :

Dompnier, B. & Pansu, P. (2010). Norme d’internalité et unités d’analyse: pour une redéfinition du statut de la mesure dans l’étude des normes sociales de jugement. Revue internationale de psychologie sociale, 23, 63-89.

Ça n’est pas parce que les centrales thermiques, les éoliennes, les panneaux photovoltaïques et les centrales nucléaires sont de la catégorie des infrastructures qui génèrent de l’électricité, que l’électrification des sociétés suffira pour atteindre la décarbonation.

Si l’industrie dont dépendent les ENS pour être entretenues et remplacées en fin de vie ne devait s’approvisionner que depuis l’énergie que cette industrie produit elle-même (l’électricité), sans source d’énergie extérieure, le projet de décarbonation serait compromis, voire disqualifié.

La confusion provient sans doute du fait que les systèmes physiques constitués par les ENS sont enchâssés dans le système physique thermo-industriel. Par défaut, nous considérerions que les propriétés des ENS seraient identiques aux propriétés des centrales thermiques, parce que toutes ces infrastructures fonctionnent concrètement, au cœur des sociétés thermo-industrielles. Mais le fonctionnement des ENS au cœur des sociétés thermo-industrielles ne dit pas qu’elles en acquerront un jour les propriétés, en particulier de s’ouvrir sur d’authentiques sources d’énergie, définissant ainsi une nouvelle classe de systèmes auto-organisés, affranchie des sociétés thermo-industrielles.

Dans l’ambition d’une transition énergétique, la focalisation sur les caractéristiques internes des convertisseurs d’énergie, au détriment de la prise en compte des conditions externes à leur existence relèverait de ce que la psychologie et les sciences de la cognition qualifient d’erreur fondamentale d’attribution. La méprise sur la détermination des causes, des conditions nécessaires (disposer de sources d’énergie) à l’effet recherché (la décarbonation) risque de ne procurer que l’illusion de la possibilité de la décarbonation, sans qu’elle ne se réalise jamais concrètement.

Sources

L’erreur fondamentale d’attribution est un biais psychologique qui consiste à accorder une importance disproportionnée aux caractéristiques internes d’un agent (caractère, intentions, émotions, connaissances, opinions) au détriment des facteurs externes et situationnels (faits) dans l’analyse du comportement ou du discours d’une personne dans une situation donnée. À l’inverse, ce biais nous incite à considérer les facteurs externes et situationnels parfois de manière disproportionnée par rapport aux caractéristiques internes quand nous sommes à l’origine de la situation.

WikipédiaPropos de ce chapitre : nous n’avons aucune raison de penser que nous sommes plus rationnels que d’autres dans la connaissance dont nous disposons de notre monde, des autres et de nous-mêmes. L’électeur libre ne peut guère changer le triste sort des agents sociaux parce que ces agents sont aujourd’hui anesthésiés et ne s’offusquent plus de leur état de soumission au pouvoir social. Le pouvoir, ainsi dégagé de son caractère problématique, peut en toute tranquillité se reproduire.

Cette anesthésie est due d’abord aux conséquences psychologiques de l’obéissance aux pouvoirs libéraux qui déclarent les gens libres et les incitent à trouver des justifications ad hoc à ce qu’ils font (rationalisation), puis à considérer que ce qu’ils font correspond parfaitement à leur nature intime (internalisation), même lorsqu’ils sont objectivement en position d’obéissance et que cette position suffit à expliquer ce qu’ils font.

Cette anesthésie à l’égard des faits de pouvoir est également due à la nature des concepts qu’utilisent les gens pour se doter d’une image d’eux-mêmes et des autres, ce qu’ils font surtout dans l’univers organisationnel où se pratique l’évaluation sociale des personnes (écoles, entreprises, dispensaires…). Ces concepts n’ont rien de scientifique et ne peuvent donner lieu à des jugements d’exactitude. Ils relèvent d’une forme de connaissance, la connaissance évaluative. Celle-ci fait apparaître comme nécessairement “humaines”, donc universelles, les utilités sociales, bien souvent arbitraires, que les agents sociaux doivent réaliser dans leur existence sociale.

Source :

Jean-Léon BEAUVOIS, Les illusions libérales, individualisme et pouvoir social. Petit traité des grandes illusions, Grenoble, Presses universitaires de Grenoble, 2005, 424 p.

L’aspect le plus surprenant du bricolage cognitif observé dans plusieurs décisions que j’ai définies comme absurdes est sa coexistence avec des comportements de type scientifique, c’est-à-dire analytiques, méthodiques, déductifs, prudents, et cela dans des organisations de culture scientifique. La même personne, ou la même organisation, amenée à utiliser un schéma cognitif rudimentaire va aussi appliquer, simultanément ou immédiatement après, une compétence de type scientifique.

Ainsi, la direction de projet des boosters de la navette Challenger qui a appliqué sur le climat de la Floride un a priori d’”homme de la rue” pratiquait par ailleurs des méthodes extrêmement rigoureuses de recherche et d’analyse. Richard P. Feynman, membre de la commission d’enquête sur l’accident de la navette Challenger, a constaté que les légèretés commises sur les moteurs d’appoint (boosters) et principaux de Challenger coexistaient avec une rigueur extrême dans le domaine de l’avionique. Le bug de la vague de froid de 1985 n’a pas été considéré comme une alerte (il allait se reproduire deux ans plus tard et provoquer la destruction de la navette), alors qu’en avionique le moindre événement inattendu, même anodin, était aussitôt étudié et que tout s’arrêtait tant qu’il n’était pas totalement élucidé et pris en compte. Le pilote qui s’est trompé de réacteur en effectuant une série de raisonnements heuristiques rudimentaires a en même temps géré d’une façon méthodique et réfléchie le détournement et l’approche de l’appareil sur l’aéroport de secours, performance saluée par les enquêteurs dans leur rapport. (…) Des ingénieurs peuvent simultanément parler d’un subtil problème de jeux de forces dans un espace à trois dimensions et présenter des transparents que ne peuvent lire de loin les participants, démontrant par là qu’ils ont suspendu leur capacité à concevoir un espace à trois dimensions et les phénomènes simples qui s’y déploient.

Il est étonnant d’observer à quel point le bricolage cognitif et la compétence analytique peuvent coexister de façon intime. Les pilotes du quadriréacteur ont passé un temps infini à raisonner de façon analytique sur le train d’atterrissage ; et en même temps ils ont pratiqué le raisonnement non conséquentialiste en ne prenant pas en compte l’obligation d’atterrir de toute façon, manifestation extrême du bricolage cognitif. (…)

LE MÉCANISME DU BRICOLAGE COGNITIF RUDIMENTAIRE

La levée de l’inhibition des processus rudimentaires ?

Cette observation d’une coexistence intime entre un bricolage cognitif et une compétence de type scientifique chez les mêmes individus est proche de la thèse de psychologie cognitive défendue notamment par Olivier Houdé (Houdé, Olivier. Rationalité, développement et inhibition. Un nouveau cadre d’analyse. Presses Universitaires de France, 1995). Selon cette thèse, les processus de raisonnement enfantin perceptifs et intuitifs, comme, par exemple, confondre nombre et longueur, ne disparaîtraient pas chez l’adulte. Ils ne s’effaceraient qu’après avoir été inhibés pour laisser intervenir la compétence analytique et déductive de type scientifique. Mais cette inhibition n’interviendrait pas systématiquement, ou ne serait pas complète, ou pourrait faire l’objet de régression. La compétence de type scientifique serait alors suspendue, laissant le champ libre à l’émergence ou à la résurgence des processus enfantins supposés révolus. “… Être intelligent c’est non seulement “reformater” (reconstruire à travers le langage), mais c’est aussi inhiber.” Olivier Houdé donne comme exemple de processus intuitif et perceptif non inhibé les réponses des adultes au test d’appariement des cartes de Wason. Pour concevoir la solution, ils reproduisent les caractères présents dans la question, ce qui est un processus d’imitation enfantin sans logique.

Dans les cas analysés dans cet ouvrage, le bricolage cognitif rudimentaire utilisé semble correspondre assez bien à cette thèse d’Olivier Houdé, en la considérant un peu différemment. Chez des pilotes, des équipages, des ingénieurs, des managers, disposant d’une compétence de type scientifique et la pratiquant, des processus de raisonnement quasi enfantins semblent avoir surgi ou resurgi, comme s’ils étaient restés en embuscade dans les esprits, prêts à bondir dès la suspension de l’inhibition qui les bride habituellement.

Source :

Christian Morel, Les Décisions absurdes, Paris, Gallimard, 2014.

Une persévérance dans la croyance et une polarisation des croyances résulteraient de ce qu’Hugo Mercier nomme “théorie argumentative du raisonnement” : nous préférerions faire évoluer nos raisonnements afin de les opposer au mieux à ceux des autres, plutôt que de les rendre compatibles avec la réalité. Nos croyances auraient par ailleurs tendance à se renforcer d’autant que nous y sommes attachés. Nos émotions nous pousseraient, en plus d’adapter nos arguments à la seule dialectique, à rechercher spécifiquement ceux qui confirmeraient nos opinions. Le “raisonnement motivé” impacterait jusqu’à la relecture par les pairs des articles scientifiques : les relecteurs auraient tendance à être plus indulgents avec les études qui vont dans le sens de leurs a priori. Une étude de 2008 montrait par l’expérience qu’une croyance pouvait être si puissante qu’elle était susceptible de persévérer, bien qu’il ait été prouvé à de multiples reprises qu’elle était fausse.

Littérature évoquée dans cet extrait :

– H. Mercier, “La théorie argumentative du raisonnement”, École pratique des hautes études, Paris, 2009.

Un raisonnement circulaire est un raisonnement qui aboutit à l’hypothèse même sur laquelle il se fonde. Détecter les limites des modèles de transition énergétique s’avèrerait d’autant plus délicat que ces modèles auraient tendance à se justifier par eux-mêmes (cet article du 20 novembre 2024 explore les raisonnements à rebours et circulaires qui traversent la littérature scientifique sur la faisabilité d’une transition énergétique).

Par exemple, dans l’objectif d’une substitution des énergies, il faut entretenir et remplacer, en fin de vie, les ENS. L’entretien et le remplacement des ENS nécessite de l’énergie. Selon les modèles actuels de substitution des énergies, puisque les ENS fournissent de l’énergie, cette énergie peut servir pour entretenir et remplacer des ENS. Cependant, le matériel scientifique énonce que tous les flux d’énergies ne favorisent pas l’organisation. Ces connaissances n’étant pas prises en compte dans le raisonnement circulaire sur la substituabilité, celui-ci ne donne que l’impression superficielle de la cohérence.

La crainte que la substitution des énergies se révèle infaisable est susceptible de motiver à la subdivision du raisonnement circulaire initial, à son déploiement en lui-même, plutôt que de l’ouvrir à des connaissances qui le disqualifieraient. Le déploiement en lui-même du raisonnement initialement biaisé se déclinerait alors en études sur l’accélération de l’électrification des usages, la promotion de la sobriété, la production d’hydrogène, le développement du stockage de l’énergie, du “power-to-x”, sur la flexibilisation de la “production” et de la consommation, sur la gestion des transferts d’énergie grâce à l’intelligence artificielle, etc.

Les modélisations fondées sur un raisonnement circulaire, bien qu’elles s’appuient sur du matériel mathématique solide, qu’elles adoptent des formes élégantes et détaillées, et aussi enrichies soient-elle de questionnements subsidiaires, s’éloignent naturellement de la question initialement posée. Les ENS ne peuvent pas exister simplement parce que les ENS existent, quand bien même on étudierait avec d’importants moyens et des calculs raffinés les processus et interactions que l’on envisagerait entre les ENS et elles-mêmes, afin de garantir leur existence.

Sources

Raisonnement circulaire. Raisonnement qui aboutit à l’hypothèse même sur laquelle il se fondait. Synon. cercle vicieux. Les aphorismes circulaires de La Rochefoucauld (É. Faure, L’Esprit des formes, 1927, p. 101). La régression à l’infini se recourbe en pétition de principe ou étiologie circulaire (Jankélévitch, Le Je-ne-sais-quoi et le presque-rien, 1957, p. 237).

Définition CNRTLTous les poissons sont des acquérites

Tous les acquérites sont des truites

Donc tous les poissons sont des truites

Dans ce cas, un test négatif consiste à essayer de former un modèle intégrant les prémisses et la négation logique de la conclusion, à savoir “certains poissons ne sont pas des truites”. Les auteurs laissent cependant un aspect non éclairci, aspect qui s’était avéré crucial pour ce qui est du test d’hypothèse : une fois que les participants s’engagent dans ce test négatif, le font-ils dans une réelle optique de falsification, ou dans une optique de vérification ? Pour le savoir, il faudrait connaître les attentes des participants : pensent-ils qu’ils vont réussir à créer un modèle leur permettant de soutenir “certains poissons ne sont pas des truites” ? Si c’est le cas, cela signifie qu’ils sont bien en train d’essayer de falsifier la conclusion originale (et non crédible). Il serait extrêmement surprenant que ce ne soit pas le cas : “certains poissons ne sont pas des truites” fait partie de leur base de connaissance, et on voit mal comment ils pourraient s’attendre à être dans l’impossibilité de trouver des arguments pour quelque chose de trivialement vrai. Il s’agirait donc là d’une réelle tentative de falsification, les participants ne finissant par accepter la conclusion non crédible comme étant valide que s’ils échouent à trouver un modèle leur permettant de soutenir sa négation logique. Cependant, dans cet unique cas dans lequel la falsification est commune, l’énoncé n’a pas été généré par les participants : au contraire, leur première intuition est une intuition de rejet.

(…)

On peut conclure cette partie sur les syllogismes sur les trois points suivants, qui concordent bien avec les prédictions de la théorie argumentative. Tout d’abord, et il s’agit du résultat le plus important, les participants ne tentent que très rarement de falsifier leur intuition initiale. Deuxièmement, le seul cas dans lequel ils s’engagent régulièrement dans une vraie stratégie de falsification est lorsque leur intuition initiale implique le rejet de la conclusion car elle n’est pas crédible. S’il s’agit bien d’une stratégie de falsification, elle ne vise pas à falsifier l’intuition initiale, mais bien à la confirmer – c’est la conclusion non crédible que les participants cherchent à falsifier. Enfin, les participants sont capables de reconnaître que leur intuition initiale ne peut pas être adéquatement soutenue et doit donc être abandonnée. Cela arrive au moins dans les deux cas suivants. Lorsqu’ils pensent initialement qu’une conclusion est impossible et que, cherchant à prouver qu’elle est impossible en montrant qu’on ne peut pas la dériver des prémisses, ils trouvent en fait un moyen de la dériver et en viennent donc à l’accepter. Et lorsque, cherchant un modèle soutenant la négation logique d’une conclusion non crédible, ils n’en trouvent pas et en viennent donc à accepter la validité de la conclusion. Le raisonnement des participants est donc biaisé car ils ne font presque que chercher à confirmer leurs intuitions initiales, mais s’ils ne peuvent la justifier, ils préfèrent donner une autre réponse – une conclusion que l’on retrouvera dans le cas du raisonnement motivé.

Source :

Hugo Mercier. La théorie argumentative du raisonnement. Philosophie. Ecole pratique des hautes études – EPHE PARIS, 2009. Français. tel-00396731

Source :

Elisabetta, Zibetti & Tijus, Charles & Poitrenaud, Sébastien. (2001). La Construction de la Représentation de l’Action Perçue. Intellectica. Revue de l’Association pour la Recherche Cognitive. 32. 123-153. 10.3406/intel.2001.1615.

Aucun système physique n’entretient son organisation à partir de sa propre énergie interne, aucun système physique ne constitue sa propre condition nécessaire*. Les efforts déployés pour optimiser l’efficacité des ENS, ou pour faire évoluer la société qui souhaite s’approvisionner avec leur énergie ne résoudront pas l’écueil de la substituabilité.

Le biais du raisonnement circulaire dans la transition – qui procure sans doute le sentiment sincère que l’existence des ENS ne dépend d’aucune variable extérieure – masque une réelle contrariété : les ENS ne pourront jamais stabiliser seules leur propre apport d’énergie.

S’extraire du raisonnement circulaire de la substitution “par elle-même” implique de poser différemment la question de la transition. Il ne s’agit pas de savoir s’il est possible de construire des ENS avec l’énergie générée par des ENS, mais d’estimer s’il est possible de fabriquer des ENS avec l’énergie du vent, du rayonnement solaire ou des atomes.

*hormis, en l’état des connaissances, l’univers.

La décarbonation des sociétés thermo-industrielles motive tant d’espoirs de compatibilisme entre l’obtention d’avantages matériels par transformation du milieu, et la protection de ce même milieu, qu’elle se serait écrite en tentant d’effacer les conclusions antérieures de la littérature scientifique, comme on écrivait autrefois des textes nouveaux en effaçant les anciens, afin d’en recycler le support.

La conceptualisation actuelle de la transition énergétique repose sur des modèles, des scénarios et des simulations dont les hypothèses de départ correspondent aux conditions de réalisation idéales d’une substitution des énergies : toutes les formes d’énergie présentes dans le milieu sont équivalentes pour les sociétés humaines ; les sociétés thermo-industrielles sont capables d’acquérir les capacités à s’approvisionner en énergie à partir de l’énergie du vent, du rayonnement solaire et des atomes ; les écueils à la substituabilité peuvent être levés par l’innovation, par l’efficacité et par l’optimisation de divers paramètres quantitatifs inhérents à l’exploitation de l’énergie.

Ces hypothèses ne paraissent pas s’appuyer sur ce qu’a énoncé la science de l’énergie jusqu’à aujourd’hui. L’équivalence des différentes formes d’énergies, l’acquisition de propriétés inédites pour les sociétés thermo-industrielles simplement parce qu’elles en auraient besoin, la capacité de l’innovation à surmonter tous les défis, ainsi que la suffisance des analyses quantitatives pour répondre à des questions qualitatives ne relèvent pas des connaissances scientifiques.

La conviction que le déploiement d’un parc suffisamment important et performant d’éoliennes, de panneaux photovoltaïques et/ou de centrales nucléaire suffirait en soi à garantir la décarbonation s’énonce en dépit des acquis théoriques et expérimentaux, comme si ceux-ci n’avaient plus cours, comme s’il était concevable de ne pas en tenir compte et de simplement écrire une science de l’énergie par-dessus les connaissances préexistantes.

Sources

Manuscrit sur parchemin d’auteurs anciens que les copistes du Moyen Âge ont effacé pour le recouvrir d’un second texte.